Что такое компакт матанализ

Научный форум dxdy

Математика, Физика, Computer Science, Machine Learning, LaTeX, Механика и Техника, Химия,

Биология и Медицина, Экономика и Финансовая Математика, Гуманитарные науки

Правила форума

В этом разделе нельзя создавать новые темы.

Если Вы хотите задать новый вопрос, то не дописывайте его в существующую тему, а создайте новую в корневом разделе «Помогите решить/разобраться (М)».

Если Вы зададите новый вопрос в существующей теме, то в случае нарушения оформления или других правил форума Ваше сообщение и все ответы на него могут быть удалены без предупреждения.

Обязательно просмотрите тему Правила данного раздела, иначе Ваша тема может быть удалена или перемещена в Карантин, а Вы так и не узнаете, почему.

Компакт в матанализе

Объясните плз что такое компакт? (можно на пальцах)

В Кудрявцеве (учебник матана, 2-й том) дано такое определение:

Ничего не пойму: на уровне выражений и логических связок вроде бы все прозрачно ясно, но все вместе.

| Заслуженный участник |

| Заслуженный участник |

| Заслуженный участник |

Понятие компактности важно для доказательства теорем существования в случае, когда не гарантирована единственность. При доказательстве обычно строится некоторая последовательность, которая, как можно надеяться, даст в пределе то, что нужно. Если она сходится. Но обычно если можно доказать сходимость, то удаётся аналогичными средствами доказать и единственность решения. А если единственности заведомо нет? Тогда и пригождаются соображения компактности: выделяем из построенной последовательности хоть что-то сходящееся, а там авось и что-то получится.

| Заслуженный участник |

| Заслуженный участник |

| Заслуженный участник |

1. Какая, нафиг, предкомпактность: ТС, наверняка, интересуется конечно-мерным случаем, в котором понятие предкомпактности малосодержательно.

2. Не понимаю, почему никто до сих пор не дал стандартного определения компактности: множество компактно, если из любого открытого покрытия можно выделить конечное подпокрытие.

Именно это и работает, когда хотят перейти от локальных к глобальным свойствам, например, от непрерывности в точке к равномерной непрерывности.

Именно так и определяю, надеюсь тут ни с кем разногласий не возникнет.

Только беда в том, что для конечномерного евклидова пространства предкомпактность множества эквивалентна его ограниченности:)

И что вам было интересно?

| Заслуженный участник |

Именно так и определяю, надеюсь тут ни с кем разногласий не возникнет.

Мне было интересно, как вы так лихо, хотя ещё не понятно как определили, предкомпактное пространство, свои соображения по поводу предкомпактного множества я высказал и они подкреплены определениями почти в любом учебнике по топологии, но насчёт пространства впервые слышу.

Кто сейчас на конференции

Сейчас этот форум просматривают: нет зарегистрированных пользователей

Достаточность. Так как М компактно, то из всякой последовательности

Отсюда и из теоремы 1 § 16 вытекает

Следствие. Всякое замкнутое ограниченное подмножество евклидова пространства является компактом.

Теорема 2. Для того чтобы метрическое пространства было компактом, необходимо и достаточно, чтобы оно было: 1) полно, 2) вполне ограничено.

Доказательство этой теоремы представляет собой дословное повторение доказательства теоремы 1 § 16.

Теорема 3. Всякий компакт К содержит конечное или счетное всюду плотное множество.

Доказательство. Так как компакт является вполне ограниченным пространством, то для каждого п в К найдется конечная

Следствие. Всякий компакт имеет счетный базис.

Теорема 4. Для того чтобы метрическое пространство R было компактом, необходимо и достаточно каждое из двух условий:

1) Любое открытое покрытие

2) Любая центрированная[9] система

Доказательство. Заметим, прежде всего, что эквивалентность сформулированных двух условий непосредственно вытекает из принципа двойственности (§ 1). Действительно, если

Условие, что из

Докажем теперь, что условие 1 необходимо и достаточно для того, чтобы R было компактом.

Необходимость. Пусть R — компакт и

Предположим, что из

Достаточность. Допустим, что пространство R таково, что из всякого его открытого покрытия можно выбрать конечное подпокрытие. Докажем, что R — компакт. Для этого достаточно доказать что R полно и вполне ограничено. Пусть

Теорема 5. Непрерывный образ компакта есть компакт.

Доказательство. Пусть X — компакт и

Расширенная комплексная плоскость, как и замкнутая числовая сфера, являются компактами.

задан 28 Фев ’17 2:06

Романенко

183 ● 1 ● 2 ● 11

60% принятых

@Романенко: я бы в первую очередь обратил внимание на неэффективность такого способа изучения математики. Берутся какие-то фразы из источников типа Википедии, потом они как-то трактуются.

Прежде всего, тут смешаны как важные понятия (компактность), так и совершенно «левые», порождающие лишние вопросы. О том, что такое компактное топологическое пространство, лучше прочитать в учебниках. Включая примеры и свойства. Что касается двумерной сферы, то это обычное школьное геометрическое понятие. Конечно, она замкнута в топологическом смысле слова (определение также лучше прочитать в книге).

@Романенко: в учебниках часто могут быть использованы ссылки на факты, считающиеся известными. Иногда могут использоваться иллюстрации, и там язык может быть менее строгим. Но у этих вещей разное назначение, и смешивать одно с другим не следует.

Для понимания этих вещей нужно хорошо понимать, что такое стереографическая проекция. Но это стандартная вещь, она много где изложена. Топологические понятия типа открытого, замкнутого, компактного множества надо знать хотя бы для частного случая, то есть для R^n. Но вообще-то, более сложные вещи лучше изучать после элементарных.

@falcao,простите, но еще хотел бы попросить: скиньте пожалуйста ссылку, где рассказывается про вот эти компакты, если такие знаете(просто предыдущие ссылки очень мне понравились(более менее понятны и просты в моем понимании))

@falcao, А вы можете посоветовать, какие-ниб вот эти элементарные вещи, которые стоит сначала изучить,т.к. очень нужно хорошо понять материал!

@Романенко: годится любой учебник, где говорится об основах общей топологии. Всё это есть даже в учебниках обычного матанализа, написанных на современной основе. Вот почти первая попавшаяся ссылка. Но надо иметь в виду, что нужную для Вас информацию придётся самостоятельно вычленять. Там есть много посторонних сведений, а я говорю о самых основных.

@falcao, о компактности говорится только в последнем параграфе, т.е. здесь все так и надо все понять до этого параграфа и получается начать с метрического пространства? если да,то первый здесь вопрос: как это ( http://prnt.sc/ee7bmt ) понять?

@falcao,абстрактным, т.е. не обязательно расстояние именно м/д точками: могут быть предметы и т.д. или Вы другое имели ввиду?

@falcao, почему одинакового объема?это как однородные величины(пример: целые числа)?

@falcao, вот эти три свойства? если да, то почему именно они важны:это же какие то очевидные свойства!

@Романенко: пример с пластилиновыми фигурками дополнительно комментировать не буду. Если он сходу не понят, значит, он неудачный. Это тот случай, когда действует принцип: «если надо объяснять, то не надо объяснять» (с)

Три свойства очевидны для обычного расстояния на прямой или плоскости. Но они не обязаны выполняться в общем случае, для произвольного правила. Я уже говорил, что правило задания «расстояния» между точками может быть каким угодно.

📈 Для чего нужен математический анализ в машинном обучении

Ilya Ginsburg

Математический анализ – основа всей высшей математики. Он необходим во многих разделах царицы наук: особенно это относится к производным и интегралам. К запуску авторского «Онлайн-курса по математике в Data Science Lite» мы начинаем публикацию серии статей об использовании математических методов в науке о данных. Сегодня рассмотрим несколько самых очевидных применений матанализа в машинном обучении, а затем перейдем к линейной алгебре и теории вероятностей.

Градиентный спуск

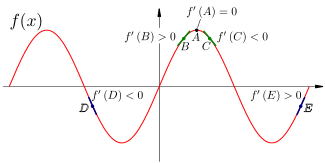

Знак производной показывает, возрастает исходная функция (производная положительна) или убывает (отрицательна). Если производная существует и равна нулю, то мы находимся в точке экстремума (минимума или максимума).

На этом свойстве производной основан самый популярный метод машинного обучения – градиентный спуск (и вообще практически все методы машинного обучения). Градиент функции нескольких переменных – это вектор ее частных производных по каждой из этих переменных:

В данном случае L – это функция потерь (Loss) нашей модели машинного обучения, а w 1. w n – внутренние параметры модели, которые должны изменяться в процессе ее обучения (веса). Функция потерь измеряет «качество» модели, она может быть очень разной в зависимости от задачи. Например, для модели, предсказывающей значение одной переменной, это может быть квадрат разности между истинным значением этой переменной и предсказанным.

Нам нужно найти глобальный минимум функции потерь в пространстве весов – то есть, такие значения весов, при которых модель будет оптимальной. Метод градиентного спуска на каждом шагу рассчитывает градиент в данной точке n-мерного пространства весов и переходит в следующую точку, двигаясь по направлению вектора градиента.

Градиентный спуск по поверхности функции потерь

Идея метода градиентного спуска очень проста: «если идти все время вниз, то когда-нибудь достигнешь дна». Чтобы узнать, в каком направлении находится «низ», мы и считаем вектор градиента.

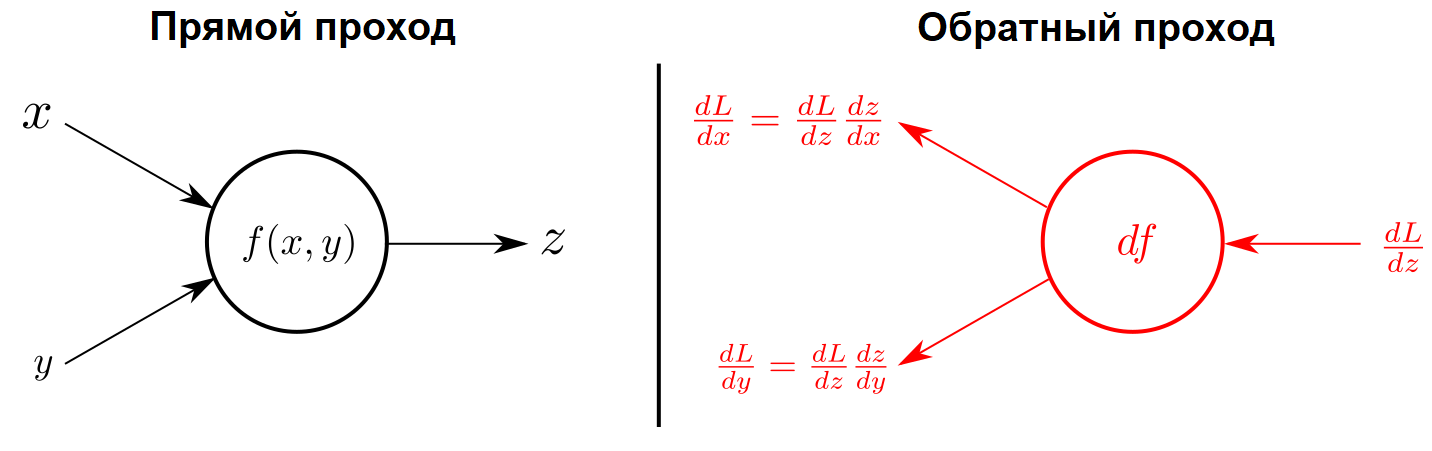

Цепное правило и back-propagation

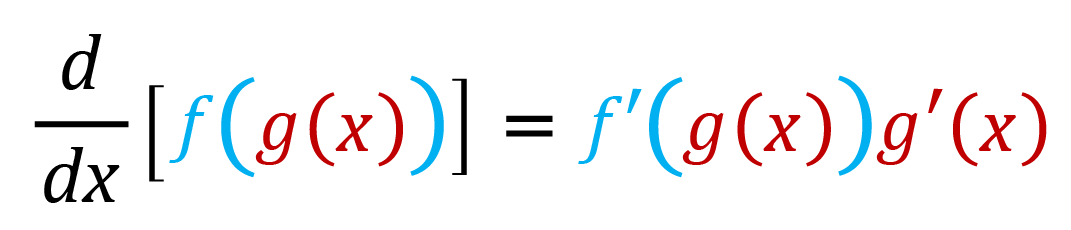

Изучая математический анализ, вы познакомитесь с цепным правилом вычисления производной – это правило вычисления производной сложной функции:

Поскольку все нейронные сети состоят из нескольких слоев, и входом каждого слоя сети, кроме первого, является выход предыдущего слоя, результат работы сети (прямого прохода) – это именно сложная функция, в которой функция активации нейронов каждого слоя выполняется над результатами функции активации предыдущего.

Для обучения нейронной сети нам нужно рассчитать градиент ее функции потерь, то есть набор производных этой функции по всем весам сети. Как видно на следующем рисунке, цепное правило позволяет представить производную по каждому весу в виде произведения более простых элементов (производных функции потерь и функций активации нейронов по их параметрам), которые мы уже можем рассчитать.

Такой метод расчета градиента называется обратным распространением ошибки, или просто обратным распространением (back-propagation). Именно этот метод дал старт широкому распространению всех видов нейронных сетей, которые изменили мир. История искусственных нейронных сетей началась еще в 1960-х, но лишь недавно появились вычислительные мощности, позволяющие реализовать обратное распространение.

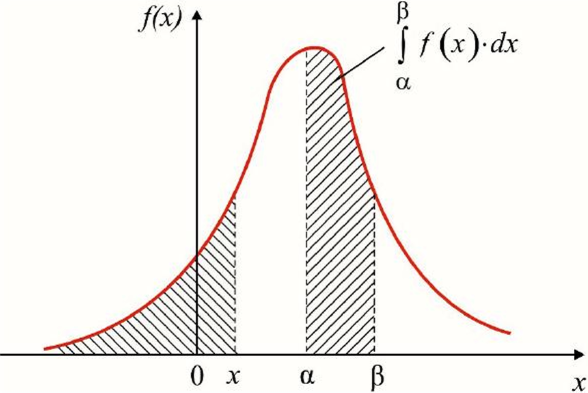

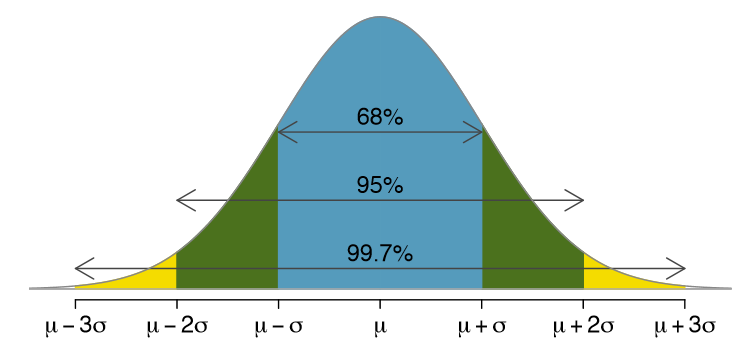

Плотность распределения вероятности

Одно из самых очевидных применений интегралов в машинном обучении – это интегрирование функции плотности распределения вероятности, занимающей центральное место в статистике. Вероятность того, что случайная величина находится в интервале между alpha и beta, равна определенному интегралу по функции плотности вероятности с этими пределами.

Именно из этой формулы следует знаменитое правило трех сигм – эмпирическое правило, согласно которому 68% значений нормально распределенной случайной величины находятся в пределах одного стандартного отклонения от среднего значения, 95% значений – в пределах двух отклонений, и 99.7% (почти все) – в пределах трех отклонений.

Заключение

Мы привели лишь несколько самых очевидных примеров применения математического анализа в машинном обучении. Менее очевидные встречаются буквально везде! Например, при выборе функции активации слоя нейронов надо учитывать опасность взрывных/исчезающих градиентов, то есть уметь анализировать поведение этой функции.

Конструирование признаков (feature engineering) – это искусство создания нужных признаков на основе исследовательского анализа данных (exploratory data analysis, EDA). Например, анализ данных может показать квадратичную зависимость целевой переменной от некоторого признака – то есть, можно ввести признак, равный квадратному корню исходного, от которого целевая переменная будет зависеть линейно. Чтобы хотя бы заметить эту квадратичную зависимость, а тем более доказать ее, нужно очень хорошо знать математический анализ.

Поэтому самым правильным ответом на вопрос «для чего в машинном обучении нужен математический анализ», будет «для всего». Нет ни одной области машинного обучения (и науки о данных вообще), в которой он бы не применялся.

В следующих статьях мы рассмотрим самые популярные приложения линейной алгебры и теории вероятностей в машинном обучении и науке о данных.

Если вы хотите наработать необходимую для изучения Data Science математическую базу, обратите внимание на онлайн-курс «Библиотеки программиста». С помощью опытных преподавателей из ведущих вузов страны сделать это будет намного проще, чем самостоятельно по книгам.