Что такое линейная регрессия в машинном обучении

Линейная регрессия в машинном обучении

Линейная регрессия ( Linear regression ) — модель зависимости переменной x от одной или нескольких других переменных (факторов, регрессоров, независимых переменных) с линейной функцией зависимости.

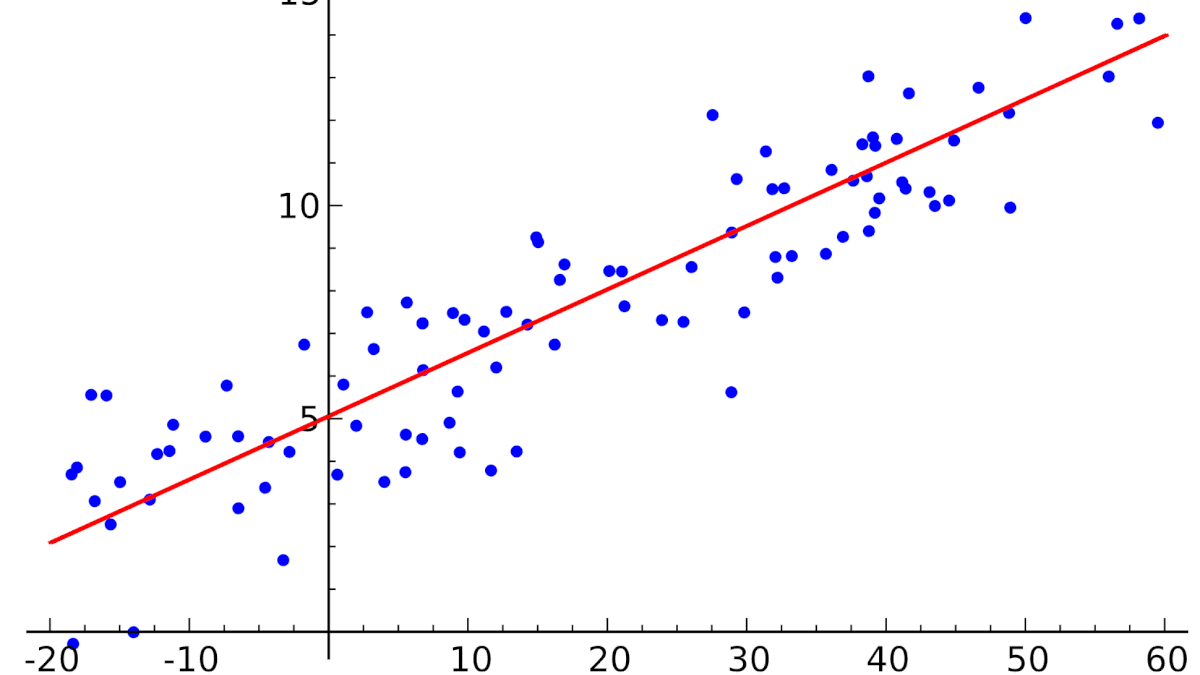

Линейная регрессия относится к задаче определения «линии наилучшего соответствия» через набор точек данных и стала прос тым предшественником нелинейных методов, которые используют для обучения нейронных сетей. В этой статье покажем вам примеры линейной регрессии.

Применение линейной регрессии

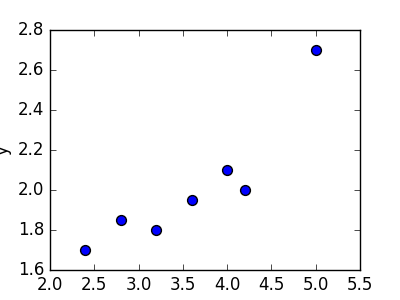

Предположим, нам задан набор из 7 точек (таблица ниже).

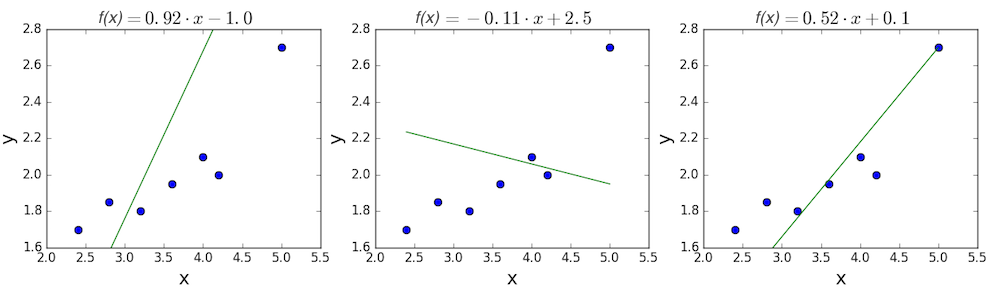

Цель линейной регрессии — поиск линии, которая наилучшим образом соответствует этим точкам. Напомним, что общее уравнение для прямой есть f (x) = m⋅x + b, где m — наклон линии, а b — его y-сдвиг. Таким образом, решение линейной регрессии определяет значения для m и b, так что f (x) приближается как можно ближе к y. Попробуем несколько случайных кандидатов:

Довольно очевидно, что первые две линии не соответствуют нашим данным. Третья, похоже, лучше, чем две другие. Но как мы можем это проверить? Формально нам нужно выразить, насколько хорошо подходит линия, и мы можем это сделать, определив функцию потерь.

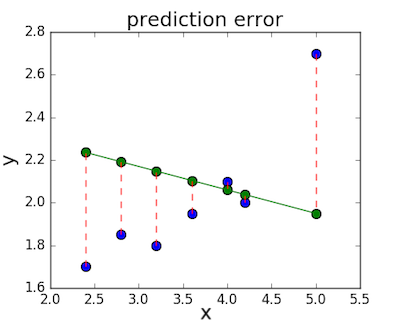

Функция потерь — метод наименьших квадратов

Функция потерь — это мера количества ошибок, которые наша линейная регрессия делает на наборе данных. Хотя есть разные функции потерь, все они вычисляют расстояние между предсказанным значением y( х) и его фактическим значением. Например, взяв строку из среднего примера выше, f(x)=−0.11⋅x+2.5, мы выделяем дистанцию ошибки между фактическими и прогнозируемыми значениями красными пунктирными линиями.

Одна очень распространенная функция потерь называется средней квадратичной ошибкой (MSE). Чтобы вычислить MSE, мы просто берем все значения ошибок, считаем их квадраты длин и усредняем.

Вычислим MSE для каждой из трех функций выше: первая функция дает MSE 0,17, вторая — 0,08, а третья — 0,02. Неудивительно, что третья функция имеет самую низкую MSE, подтверждая нашу догадку, что это линия наилучшего соответствия.

Рассмотрим приведенный ниже рисунок, который использует две визуализации средней квадратичной ошибки в диапазоне, где наклон m находится между -2 и 4, а b между -6 и 8.

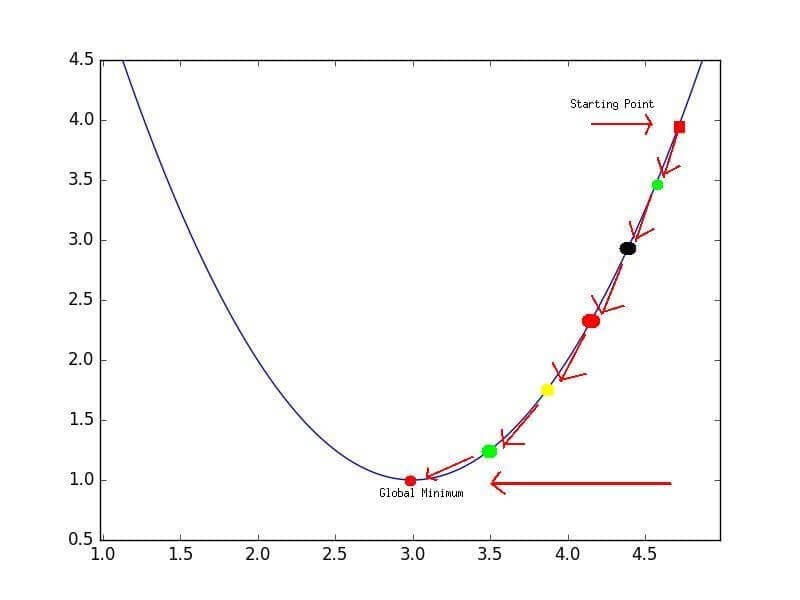

Глядя на два графика, мы видим, что наш MSE имеет форму удлиненной чаши, которая, по-видимому, сглаживается в овале, грубо центрированном по окрестности (m, p) ≈ (0.5, 1.0). Есл и мы построим MSE линейной регрессии для другого датасета, то получим аналогичную форму. Поскольку мы пытаемся минимизировать MSE, наша цель — выяснить, где находится самая низкая точка в чаше.

Больше размерностей

Вышеприведенный пример очень простой, он имеет только одну независимую переменную x и два параметра m и b. Что происходит, когда имеется больше переменных? В общем случае, если есть n переменных, их линейная функция может быть записана как:

Один трюк, который применяют, чтобы упростить это — думать о нашем смещении «b», как о еще одном весе, который всегда умножается на «фиктивное» входное значение 1. Другими словами:

Добавление измерений, на первый взгляд, ужасное усложнение проблемы, но оказывается, постановка задачи остается в точности одинаковой в 2, 3 или в любом количестве измерений. Существует функция потерь, которая выглядит как чаша — гипер-чаша! И, как и прежде, наша цель — найти самую нижнюю часть этой чаши, объективно наименьшее значение, которое функция потерь может иметь в отношении выбора параметров и набора данных.

Итак, как мы вычисляем, где именно эта точка на дне? Распространенный подход — обычный метод наименьших квадратов, который решает его аналитически. Когда есть только один или два параметра для решения, это может быть сделано вручную, и его обычно преподают во вводном курсе по статистике или линейной алгебре.

Проклятие нелинейности

Увы, обычный МНК не используют для оптимизации нейронных сетей, поэтому решение линейной регрессии будет оставлено как упражнение, оставленное читателю. Причина, по которой линейную регрессию не используют, заключается в том, что нейронные сети нелинейны.

Различие между линейными уравнениями, которые мы составили, и нейронной сетью — функция активации (например, сигмоида, tanh, ReLU или других).

Эта нелинейность означает, что параметры не действуют независимо друг от друга, влияя на форму функции потерь. Вместо того, чтобы иметь форму чаши, функция потерь нейронной сети более сложна. Она ухабиста и полна холмов и впадин. Свойство быть «чашеобразной» называется выпуклостью, и это ценное свойство в многопараметрической оптимизации. Выпуклая функция потерь гарантирует, что у нас есть глобальный минимум (нижняя часть чаши), и что все дороги под гору ведут к нему.

Но, вводя нелинейность, мы теряем это удобство ради того, чтобы дать нейронным сетям гораздо большую «гибкость» при моделировании произвольных функций. Цена, которую мы платим, заключается в том, что больше нет простого способа найти минимум за один шаг аналитически. В этом случае мы вынуждены использовать многошаговый численный метод, чтобы прийти к решению. Хотя существует несколько альтернативных подходов, градиентный спуск остается самым популярным методом.

Введение в линейную регрессию для машинного обучения

Линейная регрессия, пожалуй, один из самых известных и хорошо понятных алгоритмов в статистике и машинном обучении.

В этом уроке вы откроете для себя алгоритм линейной регрессии, как он работает и как вы можете наилучшим образом использовать его в своих проектах машинного обучения. В этом уроке вы узнаете:

Почему линейная регрессия относится как к статистике, так и к машинному обучению.

Разве линейная регрессия происходит не от статистики?

Прежде чем мы погрузимся в детали линейной регрессии, вы можете спросить себя, почему мы смотрим на этот алгоритм.

Разве это не техника из статистики?

Машинное обучение, в частности, область прогнозного моделирования в первую очередь связана с минимизацией ошибки модели или созданием наиболее точных прогнозов, за счет объяснимости. При применении машинного обучения мы будем заимствовать, повторно использовать и «воровать» алгоритмы из разных областей, включая статистику, и использовать их в этих целях.

Таким образом, линейная регрессия была разработана в области статистики и изучается в качестве модели для понимания взаимосвязи между входными и выходными числовыми переменными, но заимствована машинным обучением. Это одного и статистический алгоритм, и алгоритм машинного обучения.

Далее рассмотрим некоторые из общих имен, используемых для обозначения модели линейной регрессии.

Многоликость линейной регрессии

Когда вы начинаете смотреть алгоритм линейной регрессии, все может казаться очень запутанным.

Алгоритм существует более 200 лет уже был изучен со всех возможных точек зрения и часто каждый новых угол имеет предназначение и другое название.

При наличии одной переменной ввода (x) метод называется простой линейной регрессией. Когда существует несколько переменных входных данных, литература из статистики часто называет метод множественной линейной регрессией.

Различные методы могут быть использованы для подготовки или обучения линейной регрессии. Наиболее распространенным из которых называется Метод наименьших квадратов (или сокращенно МНК, по-английски это Ordinary Least Squares или OLS).

Теперь, когда вы знаете некоторые названия, используемые для описания линейной регрессии, давайте подробнее рассмотрим используемое представление.

Представление модели линейной регрессии

Линейная регрессия является привлекательной моделью, потому что ее представление очень простое.

Линейное уравнение присваивает масштабный коэффициент (по-английски «scale factor») к каждому входному значению X. Масштабный коэффициент представлен греческой буквой Beta (B). Добавлен также один дополнительный коэффициент, добавляющую дополнительную степень свободы (например, движение вверх и вниз по двумерном участку) и часто называют коэффициентом перехвата или смещения (по-английски «bias coefficient»).

Наиболее простая задача регрессии когда на вход подается одна переменная X и есть одно выходящее значение Y. Форма подобной модели будет:

В случае многомерных измерений (т.е. когда у нас есть более одной вводной переменной (X)), линия превращается в плоскостью или гипер-плоскости. Таким образом, представление представляет собой форму уравнения и конкретные значения, используемые для коэффициентов (например, B0 и B1 в приведенном выше примере).

Когда конкретный элемент коэффициент Beta становится нулевым, он эффективно удаляет влияние входной переменной на модель и, следовательно, влияния на прогноз модели (0 * Xi = 0). Это становится актуальным, если вы применяете методы регуляризации (о них мы расскажем отдельно), которые изменяют алгоритм обучения, чтобы уменьшить сложность моделей регрессии, оказывая давление на абсолютный размер коэффициентов, приводя некоторые из них к нулю.

Теперь, когда мы понимаем что представление, используемое для модели линейной регрессии, давайте рассмотрим некоторые способы, с помощью которых мы можем узнать это представление из данных.

Методы линейной регрессии

Изучение модели линейной регрессии означает исследование получаемых значений коэффициентов, используемых в представлении, на основе имеющихся входных данных.

В этой части урока мы кратко рассмотрим четыре метода для подготовки модели для линейной регрессии. Это не достаточно информации для реализации их с нуля, но достаточно, чтобы получить первые впечатления и компромиссы при их вычислении.

Есть еще много методов, потому что модель линейной регрессии так хорошо изучены. Важно обратить внимание что на метод наименьших квадратов, потому что это наиболее распространенный метод, используемый в целом в индустрии для задач оптимизации. Также обратите внимание метод Градиентного спуска (по-английски Gradient descent), как наиболее распространенный метод применяемый в различных классах задач машинного обучения.

Простая линейная регрессия

При простой линейной регрессии, когда у нас есть один входной параметр, мы можем использовать статистику для оценки коэффициентов.

Для этого необходимо вычислить статистические свойства на таких данных, как среднее значение, стандартные отклонения, корреляции и ковариантность. Все данные должны быть доступны для обхода и расчета статистик.

Это весело, как упражнение полезно однажды проделать в Excel, но не очень полезно на практике.

Метод Наименьших Квадратов

Когда у нас есть более одной входной переменной, мы можем использовать метод наименьших квадратов для оценки значений коэффициентов.

Процедура наименьших квадратов направлена на минимизацию суммы квадратов остатков. Это означает, что, учитывая регрессионную линию через данные, мы вычисляем расстояние от каждой входной точки Xi до линии регрессии, берем квадрат этого расстояние и суммируем все квадраты подобных расстояний. Это количество, которое обычные наименее квадратов стремится свести к минимуму.

Такой подход рассматривает данные как матрицу и использует операции линейной алгебры для оценки оптимальных значений коэффициентов. Это означает, что все данные должны быть доступны, и вы должны иметь достаточно памяти, чтобы соответствовать размеру датасета и выполнять матричные операции.

Руками подобные вычисления уже давно никто не делает (кроме как для собственного понимания или в рамках домашнего задания в школе или ВУЗе). Вы просто вызываете процедуру из библиотеки линейной алгебры. Эта процедура умеет быстро вычислять подобные задачи.

Градиентный спуск

При наличии одной или нескольких переменных можно использовать процесс оптимизации значений коэффициентов путем итеративной минимизации ошибки модели на обучающихся данных.

Эта операция называется Градиентный спуск и работает, начиная со случайных значений для каждого коэффициента.

При использовании этого метода необходимо выбрать параметр скорости обучения (альфа), который определяет размер шага улучшения, чтобы взять на себя каждую итерацию процедуры.

На практике градиентный спуск является полезным методом, когда у вас очень большой датасет либо в количестве строк, либо в количестве столбцов, которые могут не уместиться в памяти.

Регуляризация

Есть расширения обучения линейной модели, называемой методами регуляризации. Они направлены как на минимизацию суммы квадратов ошибки модели на обучающих данных (с использованием метода наименьших квадратов), но и на снижения сложности модели (например, количество или абсолютный размер суммы всех коэффициентов в модели).

Два популярных примера процедуры регуляризации линейной регрессии:

Эти методы эффективны в использовании, когда есть коллинерность во входных данных и метод наименьших квадратов соответствует обучающим данным.

Теперь, когда вы знаете некоторые методы изучения коэффициентов в модели линейной регрессии, давайте посмотрим, как мы можем использовать модель для прогнозирования новых данных.

Прогнозирование с помощью с линейной регрессии

Учитывая, что представление является линейным уравнением, сделать прогнозы так же просто, как решение уравнения для определенного набора входов.

Рассмотрим конкретный пример. Представьте, что мы прогнозируем вес человека (y) в зависимости от высоты человека (x). Наше представление модели линейной регрессии для этой проблемы будет:

вес человека = B0 + B1 * высота человека

Например, позволяет использовать B0 = 0,1 и B1 = 0,5. Давайте подставим их и рассчитаем вес (в килограммах) для человека с ростом 182 сантиметра.

вес человека = 0,1 + 0,5 * 182

Вы можете видеть, что вышеупомянутое уравнение может быть отображена как линия в двух измерениях. Коэффициент B0 является нашей отправной точкой независимо от того, какой рост у человека. Мы можем пробежать через различные высоту человека от 100 до 200 сантиметров подставив в уравнению и получить значения веса, создавая нашу линию.

Пример высоты против веса линейной регрессии

Теперь, когда мы знаем, как делать прогнозы с учетом выученной модели линейной регрессии, давайте посмотрим на некоторые правила для подготовки наших данных, чтобы максимально получить от этого типа модели.

Подготовка данных к линейной регрессии

Линейная регрессия изучается уже давно, и есть много литературы о том, как ваши данные должны быть структурированы, чтобы наилучшим образом использовать модель МНК или Градиентного спуска.

Таким образом, когда речь идет об этих требованиях и ожиданиях, они могут быть пугающими. Эти правила можно использовать скорее как практические правила при использовании алгоритмов линейной регрессии.

Используя эти эвристики и посмотреть, что лучше всего работает для вашей проблемы:

Научим основам Python и Data Science на практике

Это не обычный теоритический курс, а онлайн-тренажер, с практикой на примерах рабочих задач, в котором вы можете учиться в любое удобное время 24/7. Вы получите реальный опыт, разрабатывая качественный код и анализируя реальные данные.

Линейная регрессия

Линейная регрессия (Linear regression) — это это математическая модель, которая описывает связь нескольких переменных. Модели линейной регрессии представляют собой статистическую процедуру, помогающую прогнозировать будущее. Она применяется в научных сферах и в бизнесе, а в последние десятилетия используется в машинном обучении.

Для чего нужна линейная регрессия

Задача регрессии в машинном обучении — это предсказание одного параметра (Y) по известному параметру X, где X — набор параметров, характеризующий наблюдение.

Как работает линейная регрессия

Возьмем небольшой набор данных. Предположим, что это группа коттеджей, расположенных в одном районе. На оси Х обозначена их площадь, а на оси Y — рыночная стоимость. Чтобы увидеть, как стоимость дома зависит от его площади, построим регрессию.

Это будет простая линейная регрессия с одной переменной. Изменится площадь дома — изменится и стоимость. Для вычисления используем стандартное уравнение регрессии: f (x) = b + m⋅x, где m — это наклон линии, а b — ее сдвиг по оси Y. То есть изменение коэффициентов m и b будет влиять на расположение прямой:

Провести прямую линию через все точки на графике не получится, если они расположены в хаотичном порядке. Поэтому с помощью линейной регрессии определяется оптимальный вариант расположения этой прямой. Некоторые точки все равно останутся на расстоянии, но оно должно быть минимальным. Расчет этого минимального расстояния от прямой до каждой точки называется функцией потерь.

Для оценки точности регрессии используют разные метрики, например MSE (от англ. mean squared error — средняя квадратическая ошибка). Чем ниже MSE, тем лучше модель.

В первом случае MSE будет равна 0,17, во втором — 0,08, а в третьем — 0,02. Получается, что третья прямая лучше всего показывает зависимость цены дома от его площади.

Data Scientist с нуля

Получите востребованные IT-навыки за один год и станьте перспективным профессионалом. Мы поможем в трудоустройстве. Дополнительная скидка 5% по промокоду BLOG.

Расчет линейной регрессии в Python

Построим регрессию, чтобы узнать, как кассовые сборы фильма зависят от бюджета, который вложили в его производство.

Для расчета понадобится csv-файл, который содержит информацию о бюджетах и сборах 5 034 фильмов, которые когда-то выходили в прокат. Эти данные станут базой для исследования.

Построим модель линейной регрессии с помощью Python. Для этого нужно импортировать несколько библиотек:

Модель линейной регрессии, которую нужно будет обучить, импортируется с помощью библиотеки sklearn. В качестве X будет колонка production_budget_usd, а в качестве Y – колонка worldwide_gross_usd.

На основе этих данных определяется нужный наклон прямой и расположение относительно осей координат. Это и будет нужной линейной регрессией, по которой можно предсказать сборы собственного фильма, выбрав подходящий бюджет.

В итоге получится график того, как соотносятся бюджеты и кассы у фильмов в списке. Каждая точка — это отдельная кинолента. На оси Х показаны затраты на производство, а на оси У — сколько она заработала. Теперь через эти точки нужно провести прямую так, чтобы она была максимально близка ко всем точкам на графике.

Множественная линейная регрессия

В жизни кассовые сборы кино зависят не от одной переменной, а от совокупности разных факторов: популярности жанра, режиссера, каста актеров и затрат на промокампанию. Если рассчитать все факторы, влияющие на сборы, то уравнение изменится:

Стало f(x) = b + m1*x1 + … + mn*xn

Каждый коэффициент в нем показывает важность признаков. То есть множественная регрессия демонстрирует, как каждый параметр влияет на расположение прямой, и выбирает оптимальный вариант точно так же, как и линейная — с помощью функции потерь.

Data Scientist с нуля

Получите востребованные IT-навыки за один год и станьте перспективным профессионалом. Мы поможем в трудоустройстве. Дополнительная скидка 5% по промокоду BLOG.

Линейная регрессия для машинного обучения

Дата публикации 2016-03-25

Линейная регрессия является, пожалуй, одним из самых известных и понятных алгоритмов в статистике и машинном обучении.

В этой статье вы узнаете об алгоритме линейной регрессии, о том, как он работает и как вы можете наилучшим образом использовать его в своих проектах машинного обучения. В этом посте вы узнаете:

Вам не нужно знать какую-либо статистику или линейную алгебру, чтобы понять линейную регрессию. Это мягкое введение в технику высокого уровня, чтобы дать вам достаточно знаний, чтобы иметь возможность эффективно использовать ее в своих собственных задачах.

Разве линейная регрессия не из статистики?

Прежде чем мы углубимся в детали линейной регрессии, вы можете спросить себя, почему мы смотрим на этот алгоритм.

Разве это не техника из статистики?

Машинное обучение, в частности область прогнозного моделирования, в первую очередь связано с минимизацией ошибки модели или созданием максимально точных прогнозов за счет объяснимости. В прикладном машинном обучении мы будем заимствовать, повторно использовать и красть алгоритмы из множества различных областей, включая статистику, и использовать их для этих целей.

Как таковая, линейная регрессия была разработана в области статистики и изучается как модель для понимания взаимосвязи между входными и выходными числовыми переменными, но была заимствована машинным обучением. Это и статистический алгоритм, и алгоритм машинного обучения.

Далее, давайте рассмотрим некоторые распространенные имена, используемые для обозначения модели линейной регрессии.

Получите БЕСПЛАТНУЮ карту алгоритмов Mind

Я создал удобную карту разума из 60+ алгоритмов, организованных по типу.

Загрузите его, распечатайте и используйте.

Также получите эксклюзивный доступ к алгоритмам машинного обучения по электронной почте мини-курса.

Многие имена линейной регрессии

Когда вы начинаете изучать линейную регрессию, все может стать очень запутанным.

Причина в том, что линейная регрессия существовала так долго (более 200 лет). Он изучался со всех возможных сторон, и часто каждый угол имеет новое и другое имя.

Линейная регрессия являетсялинейная модельнапример, модель, которая предполагает линейную связь между входными переменными (x) и единственной выходной переменной (y). Более конкретно, что у можно вычислить из линейной комбинации входных переменных (х).

Когда есть одна входная переменная (x), метод называетсяпростая линейная регрессия, Когда естьнесколько входных переменныхВ литературе из статистики часто упоминается метод как множественная линейная регрессия.

Различные методы могут быть использованы для подготовки или обучения уравнения линейной регрессии из данных, наиболее распространенный из которых называетсяОбычные наименьшие квадраты, Поэтому принято называть модель, подготовленную таким образом, линейной регрессией наименьших квадратов или регрессией наименьших квадратов.

Теперь, когда мы знаем некоторые имена, используемые для описания линейной регрессии, давайте подробнее рассмотрим используемое представление.

Представление модели линейной регрессии

Линейная регрессияэто привлекательная модель, потому что представление так просто.

Представление представляет собой линейное уравнение, которое объединяет определенный набор входных значений (x), решением которого является прогнозируемый выходной сигнал для этого набора входных значений (y). Таким образом, и входные значения (x), и выходные значения являются числовыми.

Линейное уравнение присваивает один масштабный коэффициент каждому входному значению или столбцу, который называется коэффициентом и представлен заглавной греческой буквой Beta (B). Также добавляется один дополнительный коэффициент, дающий линии дополнительную степень свободы (например, перемещение вверх и вниз на двумерном графике), и его часто называют коэффициентом пересечения или смещения.

Например, в простой задаче регрессии (один x и один y) форма модели будет иметь вид:

В более высоких измерениях, когда у нас более одного входа (x), линия называется плоскостью или гиперплоскостью. Следовательно, представление представляет собой форму уравнения и конкретные значения, используемые для коэффициентов (например, B0 и B1 в вышеприведенном примере).

Часто говорят о сложности регрессионной модели, такой как линейная регрессия. Это относится к количеству коэффициентов, используемых в модели.

Когда коэффициент становится равным нулю, он эффективно устраняет влияние входной переменной на модель и, следовательно, на прогноз, сделанный из модели (0 * x = 0) Это становится актуальным, если вы посмотрите на методы регуляризации, которые изменяют алгоритм обучения, чтобы уменьшить сложность регрессионных моделей, оказывая давление на абсолютный размер коэффициентов, приводя некоторые к нулю.

Теперь, когда мы понимаем представление, используемое для модели линейной регрессии, давайте рассмотрим некоторые способы, которыми мы можем изучить это представление на основе данных.

Линейная регрессия, обучение модели

Изучение модели линейной регрессии означает оценку значений коэффициентов, используемых в представлении, с использованием имеющихся у нас данных.

В этом разделе мы кратко рассмотрим четыре метода для подготовки модели линейной регрессии. Этой информации недостаточно, чтобы реализовать их с нуля, но достаточно, чтобы понять особенности вычислений и компромиссов.

Есть много других методов, потому что модель так хорошо изучена. Обратите внимание на обычные наименьшие квадраты, потому что это наиболее распространенный метод, используемый в целом. Также обратите внимание на Gradient Descent, так как это наиболее распространенный метод обучения на уроках машинного обучения.

1. Простая линейная регрессия

С помощью простой линейной регрессии, когда у нас есть один вход, мы можем использовать статистику для оценки коэффициентов.

Для этого необходимо рассчитать статистические свойства из данных, таких как средние значения, стандартные отклонения, корреляции и ковариация. Все данные должны быть доступны для просмотра и расчета статистики.

Это весело как упражнение в Excel, но не очень полезно на практике.

2. Обычные наименьшие квадраты

Когда у нас есть более одного входа, мы можем использовать Обыкновенные наименьшие квадраты для оценки значений коэффициентов.

Обычные наименьшие квадратыПроцедура стремится минимизировать сумму квадратов невязок. Это означает, что, учитывая линию регрессии через данные, мы вычисляем расстояние от каждой точки данных до линии регрессии, возводим ее в квадрат и суммируем все квадратные ошибки вместе. Это количество, которое обычные наименьшие квадраты стремятся минимизировать.

Этот подход обрабатывает данные как матрицу и использует операции линейной алгебры для оценки оптимальных значений для коэффициентов. Это означает, что все данные должны быть доступны, и у вас должно быть достаточно памяти для размещения данных и выполнения матричных операций.

Необычно реализовать процедуру Обыкновенных наименьших квадратов самостоятельно, разве что как упражнение по линейной алгебре. Скорее всего, вы вызовете процедуру в библиотеке линейной алгебры. Эта процедура очень быстро рассчитывается.

3. Градиентный спуск

При наличии одного или нескольких входных данных вы можете использовать процесс оптимизации значений коэффициентов путем итеративной минимизации ошибки модели в ваших данных обучения.

Эта операция называетсяГрадиентный спуски работает, начиная со случайных значений для каждого коэффициента. Сумма квадратов ошибок рассчитывается для каждой пары входных и выходных значений. Скорость обучения используется в качестве масштабного коэффициента, а коэффициенты обновляются в направлении минимизации ошибки. Процесс повторяется до тех пор, пока не будет достигнута минимальная квадратичная ошибка или дальнейшее улучшение невозможно.

При использовании этого метода необходимо выбрать параметр скорости обучения (альфа), который определяет размер шага улучшения, который будет выполняться на каждой итерации процедуры.

Градиентный спуск часто преподается с использованием модели линейной регрессии, потому что это относительно просто для понимания. На практике это полезно, когда у вас очень большой набор данных по количеству строк или столбцам, которые могут не помещаться в памяти.

4. Регуляризация

Два популярных примера процедур регуляризации для линейной регрессии:

Эти методы эффективны для использования, когда во входных значениях есть коллинеарность, и обычные наименьшие квадраты будут соответствовать обучающим данным.

Теперь, когда вы знаете некоторые методы для изучения коэффициентов в модели линейной регрессии, давайте посмотрим, как мы можем использовать модель для прогнозирования новых данных.

Прогнозирование с помощью линейной регрессии

Учитывая, что представление представляет собой линейное уравнение, делать предсказания так же просто, как решить уравнение для определенного набора входных данных.

Давайте сделаем это на примере. Представьте, что мы предсказываем вес (у) от роста (х) Наше представление модели линейной регрессии для этой задачи будет:

Например, давайте использовать B0 = 0,1 и B1 = 0,5. Давайте подключим их и посчитаем вес (в килограммах) для человека ростом 182 сантиметра.

Вы можете видеть, что приведенное выше уравнение может быть построено в виде линии в двух измерениях. B0 является нашей отправной точкой независимо от того, какая у нас высота. Мы можем пробегать кучу высот от 100 до 250 сантиметров и подключать их к уравнению и получать значения веса, создавая нашу линию.

Теперь, когда мы знаем, как делать прогнозы на основе усвоенной модели линейной регрессии, давайте рассмотрим некоторые практические правила подготовки наших данных для максимально эффективного использования модели этого типа.

Подготовка данных для линейной регрессии

Линейная регрессия изучалась очень долго, и существует много литературы о том, как ваши данные должны быть структурированы, чтобы наилучшим образом использовать модель.

Таким образом, при рассмотрении этих требований и ожиданий возникает много изощренности, которая может быть пугающей. На практике вы можете больше использовать эти правила в качестве практических правил при использовании Регрессии обыкновенных наименьших квадратов, наиболее распространенной реализации линейной регрессии.

Попробуйте разные методы подготовки ваших данных, используя эту эвристику, и посмотрите, что лучше всего подходит для вашей проблемы.

УвидетьСтатья в Википедии о линейной регрессиидля превосходного списка предположений, сделанных моделью. Существует также большой список предположений оОбыкновенная статья Википедии «Наименьшие квадраты»,

Дальнейшее чтение

Есть еще много чего почитать о линейной регрессии. Начните использовать его, прежде чем приступить к чтению, но если вы хотите погрузиться глубже, ниже приведены некоторые ссылки, которые вы можете использовать.

Книги машинного обучения, в которых упоминается линейная регрессия

Это некоторые книги по машинному обучению, которые вы можете иметь или иметь к ним доступ, которые описывают линейную регрессию в контексте машинного обучения.

Сообщения о линейной регрессии

Ниже приведены некоторые интересные очерки и сообщения в блоге о линейной регрессии, с которыми я столкнулся.

Знаете еще какие-нибудь хорошие ссылки на линейную регрессию с наклонностью к машинному обучению и прогнозному моделированию? Оставьте комментарий и дайте мне знать.

Резюме

В этом посте вы обнаружили алгоритм линейной регрессии для машинного обучения.

Вы преодолели много вопросов, в том числе:

Попробуйте линейную регрессию и освоитесь с ней

У вас есть вопросы о линейной регрессии или об этом посте?

Оставьте комментарий и спросите, я сделаю все возможное, чтобы ответить.