Что такое лог на бирже

4300$ | Что такое логи и как на них заработать

Всем салют, дорогие друзья!

Сегодня поговорим о логах, расскажем, что это и с чем едят. Покажем, как мы на них зарабатываем и как можете зарабатывать вы!

Погнали!

— Обучают ли этому в Hacker Place Academy?

— Да, обучают. Мы предоставляем вам несколько топовых стиллеров, помощь по настройке, установке и всему, что вам может понадобится.

Ну а мы продолжаем!

Для начала напомним, что статья написана в образовательных целях. Мы не несем ответственности за любой возможный вред, причиненный материалами данной статьи.

Что такое логи и как с ними работать?

Пример лога со стиллера AzorUlt:

Вас ограничивает только ваша фантазия.

В целом, самое главное в работе с логами, это чтобы система воспринимала нас за своего человека. Я использую простую и доступную связку при работе, а именно Chromium + editthiscoockie + webrtc + VPN + useragent. В качестве VPN на данный момент использую Windscribe и IP Vanish. Зачастую айпи не особо много значит для нас, можно использовать любой, главное, чтобы у него не было блэков. Но с отдельными странами нужно быть более избирательными, к примеру, при работе с палкой может быть желательна подстройка под зип КХ, либо брать чистый носок.

Основное требование в работе с логами, это не пароли, как думают многие, а наличие куков. Имея куки, вы можете вытащить максимум.

Где взять логи?

Расценки, конечно же, существуют разные. Есть логи по 20р. за штуку, а есть и по 20$.

Цена лога зависит от его качества, страны, а также сервисов, которые есть внутри.

Дороже всего обойдутся логи США. Почему? За счет того, что там огромное количество банков и активных Пейпал аккаунтов. Логи, которые стоят по 20р чаще всего без выборки, и в основном там всяких хлам, по типу соц. сетей или игрушек, но может и повезти.

К примеру, покупая лог с Пейпал аккаунтом, важно проверить не только наличие пароля к нему, но и есть ли он в куках. Проверяем обычным поиском в текстовике с куками, по запросу paypal.

Если же там есть строчки и не одна, то этот лог считается хорошим.

Вот так выглядит нормальный лог

При наличии строчки с фразой «login_email», как в данном случае, Пейпал выдаст нужную нам почту автоматом. Это бывает полезно, так как зачастую бывает, что у владельца куча почт, а пароля или же логина к Пейпалу у нас нет. С таким логом,

получив хотя бы логин, мы можем попытаться подобрать пароль от аккаунта из тех, что у нас имеется.

Также, за счёт такого количества куков антифрод Пейпала относится к нам более благосклонно, и может дать вбить что-либо без предварительной его раскачки.

В случае с gmail почтой, достаточно просто проверить логирования в ней. Мотаем почту в самый низ и нажимаем кнопочку «Детали».

Нам откроется окошко с последними активностями в почте. Таким образом можно понять, были ли другие посторонние логирования помимо нашего.

По IP и стране можно понять, что за последние 3 дня, никого, кроме меня и владельца, на аккаунте не было. Кроме того, можно посмотреть письма в корзине, а то мало ли, кто-то уже пытался его «поломать». Забегая немного вперед, сразу скажу, что владельцу не приходит никаких оповещений о стороннем логировании, т.к. система приняла нас за своего человека, ведь у нас были куки.

Отлично, теперь, имея на руках целый лог с куками и паролями, можно начинать работу.)

ИМЕННО ВТОРОМУ ВАРИАНТУ МЫ И НАУЧИМ ВАС В HACKER PLACE ACADEMY.

Так выглядит панель Arkei

Как мы можем увидеть на указанных примерах, панели стиллеров выглядят примерно одинаково. Содержание паролей, логов в целом, страны/айпи, кошельки, данные с CC, файлы и т. д.

Как же получить заветные логи в нашу панельку? Есть 2 варианта. Купить инсталлы (установки нашего вируса), либо распространять самому.

При покупке инсталлов, логи мы получаем в заранее известном количестве.

В целом, важно какой будет отстук, а отстук зависит от многих факторов. От крипта (маскировки) нашего файла, от настройки форм-граббера и т.д. Если мы хотим застиллить всё что возможно, то отстук может составить и 20%, проверено на себе.))

Обычно, при покупке 1000 инсталлов, средний отстук составит около 70-80%, т.е. в панельке у нас появится 700-800 логов. Но и это ещё не всё! Часть из них может быть пустая, часть из них может быть только с куками, часть с 1-2 паролями и это абсолютно нормально. В конечном итоге, жирненьких хороших логов может получиться около 250-300.

Как мы заработали 4300$

На простой продаже логов, было лень ковырять их самим.

И заработаем еще, ведь мы еще не выжали из наших логов все соки 🙂

Информация в статье дана намеренно неполная.

Если вы хотите наконец-то начать зарабатывать хорошие деньги, не зависеть от ситуации в стране, то добро пожаловать в Hacker Place Academy.

Всем спасибо за внимание, дорогие друзья!

Всем привет. Хочу рассказать Вам о orders_log. Сам заинтересовался этой опцией недавно. 123Инсайдер уже писал про неё, его пост можете почитать тут.

Как высокочастотные роботы видят ваши ордера

Но тема по orders_log осталась не раскрыта, нигде не нашел никакого описания или упоминания об этой фишке. Поэтому статья — уникальная =)

Для начала, Full_orders_log — это список всех заявок с полной информацией по каждой заявке.

(http://www.rts.ru/a21832)

Онлайн данные по full_orders_log можно получать по plaza2. Выглядеть это будет примерно таким образом. Вид из FAR’a. На данной картинке это выглядит как полная мешанина.

full_orders_log содержит такие данные, как

Поля таблицы orders_log

Поле Тип Описание

replID i8 Служебное поле подсистемы репликации

replRev i8 Служебное поле подсистемы репликации

replAct i8 Служебное поле подсистемы репликации

id_ord i8 Номер заявки

sess_id i4 Идентификатор торговой сессии

client_code c7 Код клиента

moment t Время изменения состояния заявки

status i4 Статус заявки

action i1 Действие с заявкой

isin_id i4 Уникальный числовой идентификатор инструмента

dir i1 Направление

price d16.5 Цена

amount i4 Количество в операции

amount_rest i4 Оставшееся количество в заявке

comment c20 Комментарий трейдера

hedge i1 Признак хеджевой заявки

trust i1 Признак заявки доверительного управления

ext_id i4 Внешний номер

login_from c20 Логин пользователя, поставившего заявку

broker_to c7 Код FORTS фирмы-адресата внесистемной заявки

broker_to_rts c7 Код RTS фирмы-адресата внесистемной заявки

date_exp t Дата истечения заявки

id_ord1 i8 Номер первой заявки

broker_from_rts c7 Код РТС клиента — владельца заявки

id_deal i8 Идентификатор сделки по данной записи журнала заявок

deal_price d16.5 Цена заключенной сделки

local_stamp t Локальное время пользователя

Особенно интересно поле client_code c7 Код клиента

но оно конечно-же не транслируется и остается пустым. Учитывая предрасположенность нашей биржи к различного вида сюрпризам, можно предположить, что когда-нибудь один день с такой информацией проскочит. Или не проскочит =) впрочем и без этого поля full_orders_log остается интересным.

Если попробовать убрать лишние на ваш взгляд колонки и привести таблицу к читаемому виду, получится что-то такое. Тут я оставил только один инструмент.

На сайте ртс можно скачать один месяц истории и поиграться с данными.

http://ftp.rts.ru/pub/info/historical_data/

Сейчас год истории по всему фортсу стоит 5000баксов. На данный момент, мы занимаемся накоплением собственной истории, приглашаем жалающих присоединяться к нам, дабы страховать друг друга на случай непредвиденных обстоятельств. Обидно иметь дырку в истории за несколько дней.

Работа с потоком логов в реальном времени с помощью Heka. Опыт Яндекс.Денег

В этом материале я расскажу о том, как в Яндекс.Деньгах организована система сбора и доставки серверных логов платежных сервисов. Доставкой логов я занимаюсь весь последний год, и за это время накопилось достаточно нюансов, чтобы поделиться опытом с общественностью.

Система построена на базе стека EHK (Elasticsearch/Heka/Kibana), с прицелом на работу практически в реальном времени. Особый упор сделаю на тонкие места и нюансы обработки миллиардов строк текста в сутки.

Я верю в три вещи: мониторинг, логи и бэкапы.

Для быстрого доступа к оперативным логам в Яндекс.Деньгах используется ElasticSearch, получающий данные из почти сотни микросервисов, которые и составляют платежный сервис.

Под «оперативными» я подразумеваю логи, доступные в реальном времени: задержка доставки новых записей от файла лога до кластера Elasticsearch сейчас составляет менее секунды. Служба мониторинга всегда точно знает состояние сервиса в любой момент, а разработчики могут оперативно оценивать и корректировать поведение новой версии каждого микросервиса сразу после релиза.

Но так было не всегда. Когда пять месяцев назад я пришел в компанию, мне поставили задачу наладить работу по доставке оперативных логов сервиса до кластера ElasticSearch (далее просто ES). На тот момент использовались четыре схемы их разбора и доставки до ES:

Heka → TCP output → Heka → ES.

Heka → Apache Kafka → Apache Flume → ES.

Почти все они работали неидеально: кластер Kafka был ненадежен, Flume периодически вис, отчего ES впадал в ступор.

Логи – это на самом деле очень простая вещь: множество файлов, которые на боевых серверах быстро растут в объемах. Поэтому простые решения в этом случае — самые надежные.

Так как «чем больше в зонтике сочленений — тем выше вероятность его поломки», то я выбросил все неработающие и неоправданно сложные схемы и остановился на одной, в которой роль обработчика и транспорта выполняла бы Heka.

Heka забирает логи и по протоколу TCP отправляет их в другую Heka для дальнейшей пересылки в ElasticSearch Cluster.

Идея следующая: на каждом сервере установлена Heka, логи всех сервисов этого сервера упаковываются в бинарный протокол Protobuf и отправляются на приемную Heka для разбора, фильтрации и отправки в ES.

Почему не классический стек ELK и почему deprecated Heka, а не Logstash

С точки зрения конфигурации и состава ПО наш кластер ES выглядит следующим образом:

Две мастер-ноды: Intel Xeon 2x E5-2660, 64 ГБ ОЗУ, 2x 146 ГБ RAID-10.

Клиентская нода с установленной Kibana: Intel Xeon 2xE5-2660, 64 ГБ ОЗУ, 2×146 ГБ RAID-10.

Все ноды ES находятся в одной локальной сети и подключены к одному маршрутизатору, что позволяет осуществлять общение внутри кластера по транспортному протоколу на максимальной скорости. Такая организация заметно ускоряет размещение индексов и rebalance кластера.

В современном мире стек Elasticsearch/Logstash/Kibana стал уже практически стандартом де-факто для работы с логами. И если против Elasticsearch и Kibana нет никаких возражений, то с Logstash есть один нюанс — он создан на jRuby (написанный на Java интерпретатор языка Ruby) и требует наличия в системе JVM. Учитывая, что Яндекс.Деньги – это множество микросервисов, размещенных на сотнях физических серверов и виртуальных контейнеров, ставить в каждый из них тяжеловесные Logstash и JAVA было бы неправильно. На Heka выбор пал из-за ее простоты, надежности, легкости, умения фильтровать проходящие сообщения и отличной буферизации данных.

Что касается статуса продукта (deprecated) – для нас это не аргумент. Лук и стрелы для военных целей тоже deprecated, но это никак не мешает вам выстрелить кому-нибудь в голову с гарантированным результатом. Если же понадобится, например, нестандартный плагин или обработчик, то доработать продукт поможет целый штат опытных разработчиков.

Но это всё была теория, а при переходе к практике начались проблемы.

Дьявол прятался в объеме данных

Учитывая финансовую специфику нашей работы, почти все сервисы пишут много разной информации в логи. Для примера и понимания масштаба: объем логов некоторых из компонентов системы доходит до 250 тысяч строк в минуту.

Ни одна Heka, на каком бы мощном железе она ни стояла, в одиночку такой объём не обработает — неизбежны проседания производительности и потеря данных. Ни то, ни другое, конечно же, совершенно недопустимо, поэтому на помощь приходит HAProxy. Итоговая схема получилась следующей:

На схеме изображено общее направление трафика логов от Heka-источников до связки HAProxy + Heka.

На каждом сервере стоит одна Heka, собирающая логи микросервисов этого сервера. Данные собираются, пакуются в Protobuf и по TCP уходят на балансировщик нагрузки, обслуживающий дата-центр. Бэкендами работают HAProxy, расположенные непосредственно на дата-нодах ES, за которыми стоят пулы Heka. В свою очередь, они принимают данные, переупаковывают их в ESJson и отправляют в локальную дата-ноду по протоколу HTTP.

… и в разных форматах лог-файлов

Несмотря на то, что основным языком в компании является Java и логи выводятся через стандартную библиотеку log4j, не было единого принятого формата на момент постройки «кластера мечты». Каждый микросервис писал логи собственного типа, включая вариации в наборе выводимых полей и форматах даты-времени. Не хотелось ждать, пока разработка приведёт логи к общим форматам, поэтому движение к цели было параллельным. Одновременно с разбором существующих форматов логов заводились задачи на доработку, а по мере релиза новых версий с правильными форматами менялись и настройки сборщиков.

Перейдем к самому соку — нюансам настройки

Каждый блок проходит через несколько этапов:

Input — входной поток (это может быть файл, TCP/UDP input, данные, прочитанные из Kafka, событий Docker контейнеров и т.п.).

Splitter — тут мы указываем начало и конец каждого блока данных в потоке. Обязательный этап для многострочных данных вроде Java Stacktrace.

Decoder — описывает правила декодирования входящих данных. Мы в основном используем Regex декодеры.

Filters — этап фильтрации и изменения данных.

Encoders — кодирование потока данных под формат получателя.

Все эти этапы — просто плагины на Go и Lua. При необходимости можно написать что-нибудь своё. Например, плагин-фильтр на Lua, который будет отсекать отправку в ES записей о мониторинговых запросах к сервису; или вырезать из логов конфиденциальные данные.

Хека в древнеегипетской мифологии — бог магии. И то, что Heka позволяет делать с логами — просто волшебно.

Параметры сервера-источника логов

Разберем конфигурацию Heka на примере сервера-источника логов и файла service.toml.

Простейший случай — один файл, ротация происходит системными средствами. Если файлов много и они различаются по форматам, то следует описывать каждый парой input/decoder. За более детальным описанием лучше обратиться к официальной документации. Если что-то остается непонятным — обязательно спрашивайте в комментариях.

Так как логи могут быть многострочными (те же stacktraces), не забываем про RegexSplitter, который даёт Heka понять, где заканчивается один блок текста и начинается другой.

В match_regex описываем строки лога регулярным выражением в стандарте языка Go. Регулярные выражения в Go практически совпадают со стандартным PCRE, но есть ряд нюансов, из-за которых Heka может отказаться стартовать. Например, некоторые реализации PCRE простят такой синтаксис:

А вот GOLANG — не простит.

С помощью параметра log_errors собираем все ошибки в отдельный лог — они понадобятся позже.

Буферизация выходящего потока — одна из отличных возможностей Heka. По умолчанию она хранит выходной буфер по следующему пути:

В настройках мы ограничиваем размер каждого файла буфера объемом 100 МБ, а также устанавливаем суммарный размер кеша для каждого Output-модуля в 1 ГБ. Параметр full_action может принимать три значения:

shutdown — при переполнении буфера Heka останавливается;

drop — при переполнении буфера он начинает работать как стек, удаляя старые сообщения в очереди;

С block вы гарантированно не потеряете ни одной строки лога. Единственный минус в том, что при обрыве соединения или деградации канала вы получите резкий скачок трафика при возобновлении связи. Это связано с тем, что Heka отправляет накопленный буфер, пытаясь вернуться к обработке в реальном времени. Приёмный пул нужно проектировать с запасом, обязательно учитывая возможность таких ситуаций, иначе можно с лёгкостью провернуть DDoS самих себя.

Кстати, по поводу использования двойных и одинарных кавычек в конфигурации Heka — подразумевается следующее:

Значения переменных в одинарных кавычках по умолчанию рассматриваются как raw string. Спецсимволы экранировать не нужно.

Этот нюанс в свое время попортил мне немало крови.

Конфигурация бэкендa

Бэкенд для балансировщика — это связка из HAProxy и трёх экземпляров Heka на каждой дата-ноде ES.

В HAProxy всё довольно просто и пояснений, как мне кажется, не требует:

На каждом сервере запущено три инстанса Heka, отличающихся только портами:

В конфигурации используется MultiDecoder, так как через один порт проходят логи многих сервисов. Политика first-wins означает, что после первого совпадения дальнейший перебор декодеров прекращается.

Параметр es_index_from_timestamp нужен для указания, что дата и время для формирования имени индекса берутся не из приходящих данных, а из локального времени сервера. Позволяет избежать бардака, когда серверы работают в разных временных зонах и кто-то пишет в логи время в UTC, а кто-то в MSK.

В параметре index реализуется принцип «один сервис – один индекс», новый индекс создается каждые сутки.

Плагины Output разбирают поток данных на основании параметра message_matcher, соответствующего имени файла лога. Чтобы не перегружать сеть, Heka отправляет данные в локальную дата-ноду, на которой установлена. А уже дальше ES сам рассылает индексированные данные по транспортному протоколу между дата-нодами кластера.

Заключение

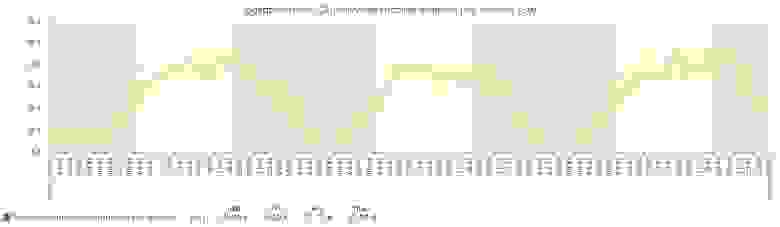

Описанная выше схема успешно работает и индексирует по 25-30 тысяч записей в секунду. Запас прочности приемных пулов Heka позволяет выдерживать пики нагрузки до 100 тыс. записей/сек:

Статистика из Zabbix.

В ElasticSearch мы храним логи за последний 21 день. Опыт показывает, что к более старым данным оперативный доступ нужен крайне редко. Но если понадобится, их всегда можно запросить с лог-серверов, хранящих данные практически вечно.

Текущее состояние кластера по данным Kopf.

Я описал только ту часть системы, которая относится к сбору и доставке логов, поэтому в следующей статье собираюсь рассказать про сам кластер ElasticSearch и его настройку. Думаю рассказать, как мы его виртуализировали, как переезжали с версии 2.2 на 5.3 и перевозили с собой 24 миллиарда записей, не потеряв при этом веру в человечество.

Может быть, добавить к рассказу что-то еще, какие-то упущенные из виду детали? Поделитесь мнением в комментариях.

Полный журнал заявок торговой системы (Full_orders_log)

При использовании услуг «Доступ к ПО FAST Gate» и «Доступ к ПО FAST Gate на срочном рынке» в качестве дополнительной опции может быть предоставлена услуга «Полный журнал заявок торговой системы» (Full_orders_log). Под услугой «Полный журнал заявок торговой системы» (Full_orders_log) понимается предоставление технической возможности получения информации обо всех транзакциях в Системе торгов Cрочного рынка ПАО Московская Биржа, осуществленных в течение Торговой сессии, в обезличенной форме.

Услуга позволяет Участнику собрать order_book неограниченной глубины, в отличие от предоставляемых Биржей агрегатов 5/20/50. Также Участник сможет получать информацию о всех удаленных или передвинутых заявках в Торговой системе.

Услуга «Полный журнал заявок торговой системы (Full_orders_log)» предоставляется Пользователю при обязательном наличии договора на предоставление Биржевой информации с предметом, соответствующим целям Пользователя при использовании Биржевой информации.

При подключении данной услуги в дополнение к тарифам, указанным в отношении соответствующей услуги «Доступ к ПО FAST Gate» и «Доступ к ПО FAST Gate на срочном рынке», взимается Абонентская плата в размере 14 000 рублей в месяц.

Уважаемые посетители сайта, чтобы отправить свое предложение или задать вопрос, используйте форму обратной связи.

Мы ценим Ваше мнение и обязательно рассмотрим Ваши вопросы и в случаях, когда это возможно, подтвердим получение Письма и предоставим письменный ответ.

В случае наличия обоснованных и существенных претензий, Биржа совместно с Экспертными Советами примет меры по разработке и реализации соответствующих изменений.

Лог: что это, зачем нужен и где его найти?

Зачем нужны лог файлы?

В некоторых ситуациях каждому пользователю ПК или сервера требуется проверить логи. Рассмотрим зачем именно нужны лог файлы.

1. Логи могут понадобится, если нужно узнать статистику по сайту. Например, логи сайтов отображают следующую информацию:

а) статистику посещаемости

б) точки входа и выхода с сайта

в) поисковые запросы, по которым приходят посетители, и наиболее популярные страницы сайта

г) поисковики, страны и браузеры посетителей

д) уровень конверсии и страницы сайта, которые никто не посещает

е) сайты, которые ссылаются на этот ресурс.

2. В случае вирусов или Дддос атаки на сайт, логи помогут быстрее выяснить причину и соответственно помочь устранить ее.

3. Для восстановления доступов испольузются логи авторизации, которые собирают данные о попытках входа.

4. В случае ошибок в работе определенного ПО, устройства или ОС, когда необходимо определить источник проблемы.

Логи (server logs) помогают контролировать работу серверной машины и в случае возникновения ошибок быстро их находить и устранять. Логи используются практически везде, где ведется запись и прослеживание истории программного процесса. В первую очередь это необходимо в целях безопасности. Для того, чтобы найти и проанализировать логи, используют специально предназначенное для этого ПО. Некоторые логи могут обладать очень большим размером, поэтому время от времени их нужно очищать. Лог файл показывает события и его непосредственный источник. Причиной события может быть:

Какие есть виды логов?

На практике видов логов может быть несколько. Рассмотрим каждый из них.

Как найти логи?

Место, где находятся логи зависит от используемого ПО, заданных настроек и пути, который заведомо установил администратор сервера.

Если вам нужно найти лог файлы сервера или хостинга, вы можете обратится и получить подробную консультацию у вашего хостинг-провайдера, где размещается ваш сайт.

Названия файлов: журнал ошибок – error.log; журнал доступов – log; основной журнал – syslog; журнал загрузки системы – dmesg.

В ОС Windows свой способ структуризации логов, в котором выделяют уровни событий: подробности; сведения; предупреждение; ошибка; критический. Пользователь может сортировать и фильтровать записи, в зависимости от того, что именно ему нужно.

Что делать с логами?

Лог файлы могут понадобится во многих ситуациях при работе с сайтов, ПК или сервером. Но обратите внимания, что логи не хранятся вечно, поэтому если появилась необходимость проверить их, то следует это делать своевременно. Например, часто хостинг-провайдеры хранят логи до 14 дней, а далее они удаляются и записываются новые. Поэтому если ваш сайт взломали более нескольких недель назад, то установить причину по логам не получится, если логи уже удалены.

Даже беглый анализ логов может помочь выяснить причины чрезмерной нагрузки на сайт, поэтому если вам нужна помощь, чтобы разобраться с логами и исправить возникшие ошибки работы сервера, обращайтесь в техническую поддержку ГиперХост.

Включение и выключение записей логов на сервере происходит в панели управления. В большинстве случаев эта функция доступна в разделе панели Журнал или Логи. Более детально об этом вы можете уточнить непосредственно у вашего хостера.