какие существуют методы доступа

Тема 2. Методы доступа

Метод доступа – это способ определения того, какая из рабочих станций сможет следующей использовать ЛВС. То, как сеть управляет доступом к каналу связи (кабелю), существенно влияет на ее характеристики. Примерами методов доступа являются:

— множественный доступ с прослушиванием несущей и разрешением коллизий (Carrier Sense Multiple Access with Collision Detection – CSMA/CD);

— множественный доступ с передачей полномочия (Token Passing Multiple Access – TPMA) или метод с передачей маркера;

— множественный доступ с разделением во времени (Time Division Multiple Access – TDMA);

— множественный доступ с разделением частоты (Frequency Division Multiple Access – FDMA) или множественный доступ с разделением длины волны (Wavelength Division Multiple Access – WDMA).

CSMA/CD

Алгоритм множественного доступа с прослушиванием несущей и разрешением коллизий приведен на рис. 4.5.

Рис. 4.1 Алгоритм CSMA/CD

Метод множественного доступа с прослушиванием несущей и разрешением коллизий (CSMA/CD) устанавливает следующий порядок: если рабочая станция хочет воспользоваться сетью для передачи данных, она сначала должна проверить состояние канала: начинать передачу станция может, если канал свободен. В процессе передачи станция продолжает прослушивание сети для обнаружения возможных конфликтов. Если возникает конфликт из-за того, что два узла попытаются занять канал, то обнаружившая конфликт интерфейсная плата, выдает в сеть специальный сигнал, и обе станции одновременно прекращают передачу. Принимающая станция отбрасывает частично принятое сообщение, а все рабочие станции, желающие передать сообщение, в течение некоторого, случайно выбранного промежутка времени выжидают, прежде чем начать сообщение.

Все сетевые интерфейсные платы запрограммированы на разные псевдослучайные промежутки времени. Если конфликт возникнет во время повторной передачи сообщения, этот промежуток времени будет увеличен. Стандарт типа Ethernet определяет сеть с конкуренцией, в которой несколько рабочих станций должны конкурировать друг с другом за право доступа к сети.

TPMA

Алгоритм множественного доступа с передачей полномочия, или маркера, приведен на рис. 4.6.

Рис. 4.1 Алгоритм TPMA

Метод с передачей маркера – это метод доступа к среде, в котором от рабочей станции к рабочей станции передается маркер, дающий разрешение на передачу сообщения. При получении маркера рабочая станция может передавать сообщение, присоединяя его к маркеру, который переносит это сообщение по сети. Каждая станция между передающей станцией и принимающей видит это сообщение, но только станция – адресат принимает его. При этом она создает новый маркер.

Маркер (token), или полномочие, – уникальная комбинация битов, позволяющая начать передачу данных.

Каждый узел принимает пакет от предыдущего, восстанавливает уровни сигналов до номинального уровня и передает дальше. Передаваемый пакет может содержать данные или являться маркером. Когда рабочей станции необходимо передать пакет, ее адаптер дожидается поступления маркера, а затем преобразует его в пакет, содержащий данные, отформатированные по протоколу соответствующего уровня, и передает результат далее по ЛВС.

Пакет распространяется по ЛВС от адаптера к адаптеру, пока не найдет своего адресата, который установит в нем определенные биты для подтверждения того, что данные достигли адресата, и ретранслирует его вновь в ЛВС. После чего пакет возвращается в узел из которого был отправлен. Здесь после проверки безошибочной передачи пакета, узел освобождает ЛВС, выпуская новый маркер. Таким образом, в ЛВС с передачей маркера невозможны коллизии (конфликты). Метод с передачей маркера в основном используется в кольцевой топологии.

Данный метод характеризуется следующими достоинствами:

— гарантирует определенное время доставки блоков данных в сети;

— дает возможность предоставления различных приоритетов передачи данных.

Вместе с тем он имеет существенные недостатки:

— в сети возможны потеря маркера, а также появление нескольких маркеров, при этом сеть прекращает работу;

— включение новой рабочей станции и отключение связаны с изменением адресов всей системы.

TDMA

Множественный доступ с разделением во времени основан на распределении времени работы канала между системами (рис.4.7).

Доступ TDMA основан на использовании специального устройства, называемого тактовым генератором. Этот генератор делит время канала на повторяющиеся циклы. Каждый из циклов начинается сигналом Разграничителем. Цикл включает n пронумерованных временных интервалов, называемых ячейками. Интервалы предоставляются для загрузки в них блоков данных.

Рис. 4.1 Структура множественного доступа с разделением во времени

Данный способ позволяет организовать передачу данных с коммутацией пакетов и с коммутацией каналов.

Первый (простейший) вариант использования интервалов заключается в том, что их число (n) делается равным количеству абонентских систем, подключенных к рассматриваемому каналу. Тогда во время цикла каждой системе предоставляется один интервал, в течение которого она может передавать данные. При использовании рассмотренного метода доступа часто оказывается, что в одном и том же цикле одним системам нечего передавать, а другим не хватает выделенного времени. В результате – неэффективное использование пропускной способности канала.

Второй, более сложный, но высокоэкономичный вариант заключается в том, что система получает интервал только тогда, когда у нее возникает необходимость в передаче данных, например при асинхронном способе передачи. Для передачи данных система может в каждом цикле получать интервал с одним и тем же номером. В этом случае передаваемые системой блоки данных появляются через одинаковые промежутки времени и приходят с одним и тем же временем запаздывания. Это режим передачи данных с имитацией коммутации каналов. Способ особенно удобен при передаче речи.

FDMA

Доступ FDMA основан на разделении полосы пропускания канала на группу полос частот (Рис. 4.8), образующих логические каналы.

Широкая полоса пропускания канала делится на ряд узких полос, разделенных защитными полосами. Размеры узких полос могут быть различными.

При использовании FDMA, именуемого также множественным доступом с разделением волны WDMA, широкая полоса пропускания канала делится на ряд узких полос, разделенных защитными полосами. В каждой узкой полосе создается логический канал. Размеры узких полос могут быть различными. Передаваемые по логическим каналам сигналы накладываются на разные несущие и поэтому в частотной области не должны пересекаться. Вместе с этим, иногда, несмотря на наличие защитных полос, спектральные составляющие сигнала могут выходить за границы логического канала и вызывать шум в соседнем логическом канале.

Рис. 4.1 Схема выделения логических каналов

В оптических каналах разделение частоты осуществляется направлением в каждый из них лучей света с различными частотами. Благодаря этому пропускная способность физического канала увеличивается в несколько раз. При осуществлении этого мультиплексирования в один световод излучает свет большое число лазеров (на различных частотах). Через световод излучение каждого из них проходит независимо от другого. На приемном конце разделение частот сигналов, прошедших физический канал, осуществляется путем фильтрации выходных сигналов.

Метод доступа FDMA относительно прост, но для его реализации необходимы передатчики и приемники, работающие на различных частотах.

Вопросы

1. Что такое топология?

2. Перечислить наиболее используемые типы топологий?

3. Охарактеризовать топологию Общая шина и привести примеры использования данной топологии.

4. Какие сетевые технологии используют топологию Общая шина?

5. Охарактеризовать топологию Кольцо и привести примеры этой топологии.

6. В каких случаях используют топологию Кольцо?

7. Охарактеризовать топологию Звезда и привести примеры использования этой топологии.

8. К какой топологии относится сеть при подсоединении всех компьютеров к общему концентратору?

9. Привести примеры и охарактеризовать древовидную топологию.

10. Что такое ячеистая топология и в каких случаях она используется?

11. Что такое метод доступа и как влияет метод доступа на передачу данных в сети?

12. Какие существуют методы доступа?

13. Охарактеризовать метод доступа с прослушиванием несущей и разрешением коллизий.

14. При каком методе доступа обе станции могут одновременно начать передачу и войти в конфликт?

15. В каких сетевых технологиях используется метод CSMA/CD?

16. Охарактеризовать метод доступа с разделением во времени и перечислить в каких случаях используется данный метод.

17. Что такое маркер?

18. В каком случае рабочая станция может начать передачу данных при использовании метода доступа с передачей полномочия?

19. Охарактеризовать метод доступа с передачей полномочия.

20. Охарактеризовать метод множественного доступа с разделением частоты.

21. Какие существуют варианты использования множественного доступа с разделением во времени?

Методы доступа. Наиболее популярные ситуации

Статья в первую очередь расчитана на начинающих разработчиков, либо для тех, кто только начинает переходить от процедурного стиля программирования к ООП, посему матерых гуру просьба не вгонять в минуса 🙂

Права доступа к свойствам и методам — это на первый взгляд всего лишь три слова: private, protected и public. Но что скрывается за ними? Какие преимущества это дает в разработке? И как их правильно использовать? Здесь, как и во всех других аспектах программирования, без практики не разобраться…

Одна из трех основных концепций ООП — наследование (другие две: инкапсуляция и полиморфизм). Вобщем-то именно для нее и были реализованы права доступов. Основанная идея наследования: Дочерний объект, при наследовании (extend) родителя перенимает себе все родительские методы и свойства, а так же может обзавестись своими собственными. Понимая эту базу, можно перейти в всему что находится ниже…

Private — объявляет метод или свойство доступным только в том классе в котором он присутствует. Тоесть к private методам и свойствам мы не можем обращаться ни из объектов, ни из дочерних классов.

Protected — объявляет метод или свойство защищенными. Тоесть такими, которые не могут быть доступны из объекта, реализующего класс, но вполне может быть использовано в дочерних классах.

Public — публичный. Классы и методы, объявленные public, могут быть доступны как внутри самого класса, так и в дочерних классах и в объектах, реализовавших класс.

Сразу хочу заметить, что при наследовании, методы доступа изменяться могут только к более лояльным. тоесть в следующей последовательности, но не обратно: private → protected → public

Так же методы могут быть final тоесть такими, которые невозможно переопределить в классах потомках.

Вобщем-то все методы доступа используются исключительно для самодокументации кода и не несут никакой логической составляющей, так что и без них жизнь только тяжела, но не невозможна, что доказывает РНР4, в котором все методы и свойства были публичными…

Практика

Похожим способом ведут себя и сеттеры (setter\’s), когда нам необходимо иметь возможность установить значение переменной, но не читать ее напрямую, так как она, к примеру, должна быть преобразована прежде чем быть использованной. Пример метода сеттера:

Еще одним вариантом реализации доступа к методам, когда метод должен быть отовсюду доступен только для чтения, является введение \«псевдо-свойства\»:

if (empty($value)) <

$value = //. тут значение создается по каким-то известным параметрам и повлиять извне на него мы никак не сможем

>

Хорошей практикой является сокрытие всех свойств методом private и, в зависимости от нужд, создавать для них сеттеры или геттеры, но нужно быть внимательным, что если для свойства существует и сеттер и геттер, а дополнительной логики обработки данных нет, то не проще ли их убрать, а свойство сделать публичным? 🙂

Методы доступа

В локальную сеть всегда входит несколько абонентов, причем каждый из них, как правило, работает самостоятельно и в любой момент может обратиться к сети. Однако, если два компьютера попытаются передавать данные одновременно, их пакеты «столкнутся» и будут испорчены – возникнет так называемая коллизия. Для упорядочения использования сети различными абонентами, предотвращения или разрешения конфликтов между ними требуется управление доступом к сети. Существует три основных метода доступа:

— множественный доступ с контролем несущей и обнаружением коллизий;

— множественный доступ с контролем несущей и с предотвращением коллизий;

— доступ с передачей маркера;

— доступ по приоритету запроса.

Первый метод применяется исключительно в сетях с логической общей шиной. Все компьютеры такой сети имеют непосредственный доступ к общей шине, поэтому она может быть использована для передачи данных между двумя компьютерами. Одновременно все компьютеры сети имеют возможность немедленно (с учетом задержки распространения сигнала по физической среде) получить данные, которые любой из компьютеров начал передавать на общую шину. Говорят, что кабель, к которому подключены все станции, работает в режиме множественного доступа (Multiply Access, MA). Суть метода состоит в следующем:

а) станция, желающая передать данные, должна убедиться, что разделяемая среда свободна. Это достигается прослушиванием основной гармоники сигнала, которая называется несущей частотой (carrier-sense, CS). Признаком занятости среды является отсутствие на ней несущей частоты, которая при манчестерском способе кодирования равна 5 – 10 МГц, в зависимости от последовательности единиц и нулей, передаваемых в данный момент. Если среда свободна, то узел может начать передачу данных. После окончания передачи данных все узлы сети обязаны выдержать технологическую паузу (Inter Packet Gap) в 9,6 мкс. Эта пауза нужна для приведения адаптеров в исходное состояние, а также для предотвращения монопольного захвата среды одной станцией;

б) после окончания технологической паузы узлы имеют право начать передачу данных, так как среда свободна. При передаче данных все станции одновременно наблюдают за возникающими на кабеле сигналами. Если передаваемые и наблюдаемые сигналы отличаются, то фиксируется обнаружение коллизии (collision detection, CD) (столкновения пакетов);

в) если станция обнаружила коллизию, то, для увеличения вероятности скорейшего обнаружения этого столкновения всеми станциями сети, она прерывает передачу своих данных и усиливает ситуацию коллизии посылкой в сеть специальной последовательности из 32 бит,называемой jam-последовательностью;

На рис.2.8. показана схема возникновения и распространения коллизии.

Рисунок 2.8. Схема возникновения и распространения коллизии

Чем больше компьютеров в сети, тем интенсивнее сетевой трафик, и число коллизий возрастает, а это приводит к замедлению сети.

Для уменьшения интенсивности возникновения коллизий нужно либо уменьшить трафик, сократив, например, количество узлов в сегменте или заменив приложения, либо повысить скорость протокола.

Второй метод – самый непопулярный из всех методов доступа. Используя CSMA/CA, каждый компьютер перед передачей данных в сеть сигнализирует о своем намерении, поэтому остальные компьютеры «узнают» о готовящейся передаче и могут избежать коллизий. Однако широковещательное оповещение увеличивает общий трафик сети и уменьшает ее пропускную способность. Поэтому CSMA/CA работает медленнее, чем CSMA/CD.

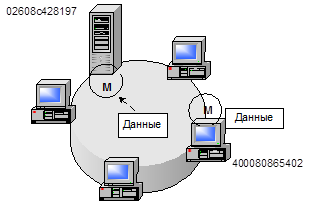

Метод доступа с передачей маркера заключается в следующем:

а) специальный пакет, называемый маркером (token), циркулирует по кольцу от компьютера к компьютеру, синхронизируя работу абонентов сети. Компьютер, желающий послать данные в сеть, должен дождаться прихода свободного маркера и захватить его. Захватив маркер, компьютер помечает его как занятый (разбивает на кадры, в заголовке которых находится информация об адресе получателя и отправителя), добавляет к нему свой пакет и отправляет полученную связку (маркер + пакет) дальше в кольцо;

б) каждый компьютер, получивший эту связку, проверяет, ему ли адресован пакет. Если пакет не его, компьютер отправляет его дальше по «кольцу». Надо учесть, что в данном случае пакет обязательно должен быть принят каждым компьютером, и только потом отправлен (или не отправлен) дальше;

в) компьютер, распознавший пакет, который адресован ему, принимает этот пакет, устанавливает в маркере специально выделенный бит подтверждения и отправляет связку из маркера и пакета дальше;

г) передавший компьютер получает обратно свою посылку, прошедшую через все кольцо и снова посылает маркер в сеть. При этом ему уже известно принят его пакет адресатом или нет из анализа бита подтверждения.

На рис.2.9. показан метод доступа с передачей маркера.

Рисунок 2.9. Метод доступа с передачей маркера

Доступ по приоритету запроса(demand priority) – относительно новый метод доступа, разработанный для сети Ethernet со скоростью передачи данных 100 Мбит/с – 100VG – AnyLAN.

Этот метод учитывает своеобразную конфигурацию сетей 100VG-AnyLAN, которые состоят только из коммутаторов и оконечных устройств. Коммутатор управляет доступом к кабелю, последовательно опрашивая каждый узел в сети и выявляя запросы на передачу. Станция, желающая передать пакет, посылает специальный низкочастотный сигнал коммутатору и указывает его приоритет. В сети 100VG – AnyLAN используется два уровня приоритетов – низкий и высокий. Низкий уровень приоритета соответствует обычным данным (файловая служба, служба печати и т.п.), а высокий приоритет соответствует данным, чувствительным к временным задержкам (например, мультимедиа).

Если сеть свободна, то коммутатор разрешает передачу пакета. После анализа адреса получателя в принятом пакете коммутатор автоматически отправляет пакет станции назначения. Если сеть занята, коммутатор ставит полученный запрос в очередь, которая обрабатывается в соответствии с порядком поступления запросов и с учетом приоритетов (вначале обрабатывается запрос с более высоким приоритетом). Если к порту подключен другой коммутатор, то опрос приостанавливается до завершения опроса коммутатором нижнего уровня.

В сетях с использованием доступа по приоритету запроса связь устанавливается только между компьютером – отправителем, коммутатором и компьютером – получателем. Такой вариант более эффективен, чем CSMA/CD, где передача ведется для всей сети. Кроме того, в таких сетях каждый компьютер может одновременно передавать и принимать данные, поскольку в них применяется восьмипроводной кабель, по каждой паре проводов которого сигналы передаются с частотой 25 МГц. На рис.2.10 показан метод доступа по приоритету запроса.

Рисунок 2.10. Метод доступа по приоритету запроса

Топология

Среди топологических схем наиболее популярными являются (см. рис. 4.1):

Рис. 4.2. Примеры сетевых топологий

Используется и немалое количество других топологий, которые являются комбинациями уже названных. Примеры таких топологий представлены на рис. 4.3.