yoba parser что это за программа avtozenno

Сервис по продвижению сайтов в интернете

Анализ, описание, отзывы avtozenno.ru, снимки экрана, обзор сайта avtozenno.ru, а так же анализ на наличие возможности его продвижения методом регистрации в различных справочниках, каталогах, сервисах, методом распространения информации по интернету.

Автоматизация в сети

avtozenno.ru

Адрес сайта: avtozenno.ru

Возможный Alias: www.avtozenno.ru

Вероятно читается как: «автозенно ру»

Описание: Комплексная автоматизация процессов в интернете

Найденные ключевые фразы: Не определено

Конкурентов в поиске: Примерно 2596

Показатели сайта: На данный момент сайт avtozenno.ru имеет низкие показатели и низкую посещаемость. Сайт сложно находить соискателям в поиске Яндекса и Гугла. Вероятность того, что сайт в данный момент не продвигается ни одним из известных способов 85%

— Яндекс ИКС

— PR-CY RANK

— ТРАСТ

Наличие H1 тегов: Автоматизация в сети

Наличие H2 тегов: Сообщения

Наличие H4 тегов: Не определено

Наличие H5 тегов: Не определено

Количество внутренних ссылок: 104

Количество исходящих (внешних) ссылок: 13

Картинок/изображений на главной (всего): 24

Описания картинок: Изображение

Наличие вирусов: Не найдено (OK)

Наличие вредоносного кода: Не найдено (OK)

Наличие в списке запрещённых: Нет, всё в порядке (OK)

Размер главной страницы (html кода): 220294 Байт (OK)

Скорость открытия главной страницы (сек.): 1.453 (OK)

IP адрес сайта: 216.239.36.21 (any-in-2415.1e100.net)

NS сервера: ns1.reg.ru, ns2.reg.ru

Код ответа сервера: 200 (OK)

Инструкции для роботов (из robots.txt):

Эта страница просмотрена: 562 раз с момента последнего анализа

Тех.оценка: 3.1 из 5

Дата последнего анализа: 19.01.2020г. в 21:29

Результат анализа и ожидаемый эффект:

Возможность продвижения: Да

Найденные проблемы с сайтом: Нет

Ожидаемый прирост ИКС показателя: Плюс 20-60 пунктов к текущему показателю.

Повышение позиций в поиске Яндекса: Да (вероятность 100%, эффективность 95%)

Повышение позиций в поиске Гугла: Да (вероятность 100%, эффективность 87%)

Получение новых ключевых фраз в поиске: Да (от 3 до 7 новых ключевых фраз)

Ожидаемое повышение посещаемости: Повышение в 4-8 раз, не менее чем на 150 человек в сутки, не более чем на 550 человек в сутки.

Информацию об услуге Вы можете получить тут, а с примерами приблизительного эффекта можно ознакомится тут.

Отзывы о сайте avtozenno.ru:

По вопросам продвижения и рекламы обращайтесь на контакты:

Стоимость услуги: 1200р.

Задействовано сайтов: 4468шт.

15.11.2021: В базу добавлено ещё 37 новых сайтов. Теперь мы можем разместить Вашу информацию ровно на 4468 сайтах!

13.10.2021: Сегодня мы произвели очередное обновление базы сайтов. В базу добавлено 42 новых сайта.

08.08.2021: Сегодня мы добавили в нашу базу 69 новых сайта. Все заказы за последние 3 недели будут автоматически опубликованы на этих новых сайтах в течение 3х дней совершенно бесплатно.

14.07.2021: В связи с переездом нашего сервиса на более мощный сервер, в ближайшие 2 дня мы будем принимать в работу Ваши заявки в опозданием в несколько часов. Почта в эти дни будет работать с перебоями, если долго не отвечаем, значит мы не получили Ваше письмо, в этом случае позвоните нам или напишите повторно. Переезд увеличит качество услуги и сократит скорость выполнение заявок как минимум в 2 раза.

17.06.2021: В базу добавлено 38 новых сайтов.

29.04.2021: В период майских праздников мы работаем но не круглосуточно, а с 10 до 17 часов (по МСК) ежедневно!

16.04.2021: Вчера Яндекс обновил ИКС, проверьте свой ИКС, он вырос почти у всех сайтов, что были в работе!

26.03.2021: В рабочую базу добавлено 56 новых сайта.

Сообщения в этом чате видны всем!

Для общения нужно авторизоваться в Л.К.

Парсер – что это такое простыми словами, как его настроить и пользоваться программой для парсинга сайтов

24 июня 2020 Опубликовано в разделах: Азбука терминов. 86183

Есть приложения, которые позволяют автоматизировать множественные процессы интернет-маркетинга. Они необходимы многим бизнесменам, которые либо хотят использовать сбор информации с конкурирующих веб-источников, либо защитить себя от подобного «воровства» контента. В любом случае, работая с интернет-ресурсом важно знать о парсинге сайта – что это такое (мы расскажем простыми словами) и как настроить и пользоваться парсером данных.

Parsing

Данный механизм действует по заданной программе и сопоставляет определенный набор слов, с тем, что нашлось в интернете. Как поступать с полученной информацией, написано в командной строке, называемой «регулярное выражение». Она состоит из символов и задает правило поиска.

Фактически понятие переводится с английского языка как семантический анализ или разбор. Но термин, применяемый в технологиях создания и наполнения вебсайта, имеет более широкое значение. Это процедура, действие, предполагающее многостороннее исследование страницы, документа, целого раздела на предмет нахождения лексических, грамматических единиц или иных элементов (не только текста, но и видео-, аудио-контента) с последующей систематизацией. Искомые сведения находятся и преобразуются, они подготавливаются для дальнейшей работы с ними. Еще можно сказать, что это быстрая оценка и скорая обработка интернет-ресурса, данных с него. Вручную подобный процесс занял бы много времени, но автоматизация его значительно упрощает.

Таким образом, парсер – это программа для парсинга ключевых слов сайтов. Она настраивается, в нее вводятся параметры поиска и прочие указания, чтобы получить семантическое ядро или анализ карточек товаров для интернет-магазина.

Исходником может быть ваш собственный веб-ресурс (для аналитики и принятия последующих решений), сайт конкурента, страничка из социальных сетей и пр. Полученным результатом можно будет пользоваться в дальнейшем по усмотрению владельца. Приведем понятный пример. По такому принципу работают поисковые системы, когда они анализируют страницы на релевантность, наличие ключевых слов из запроса и соответствие тематике, а затем на основе полученных сведений автоматически формируется выдача.

Законно ли использовать парсинг семантического ядра с сайтов конкурентов

Посмотрим на это с такой стороны. Если ресурс является открытым для пользователей, то вся представленная информация может собираться вручную. А если это доступно, то и применение специального софта для автоматизации процесса не является противозаконной. Опять же при условии, что доступ разрешен всем.

Сквозная аналитика

Это услуга, которая признана дать отчет о результативности интернет-рекламы. То есть с помощью сервиса собираются данные с рекламных площадок, связывает их со сведениями об обращениях и продажах. Анализируя это, можно понять, насколько эффективно было использование того или иного метода продвижения. Таким образом возможно выявить, какие каналы являются затратными, но не приносят достаточно выгодного результата, это помогает оптимизировать бюджет.

Такую услугу постоянной аналитики предлагает компания SEMANTICA в комбинации с комплексным продвижением сайтов. Клиенты этого агентства могут наблюдать за тем, какой результат он получает от того или иного действия, проекта. Все сведения предоставляются в виде отчетов, диаграмм.

Для чего нужен парсинг

Первое с чем сталкивается начинающий руководитель – вокруг много информации, слишком большое ее количество затрудняет возможность оперировать большинством ее массы вручную.

Достоинства применения программ для парсинга каталога товаров с сайта для интернет-магазина

Сравним автоматический режим сбора с ручным, преимущества:

Ограничения: почему бывает сложно парсить

Многие задумываются о том, как защитить сайт от парсинга, потому что не хотят терять уникальность контента. Поэтому используют различные программы, которые запрещают доступ к ресурсу ботам.

Как работает парсинг и какой контент можно парсить своими руками или автоматически

Вам удастся получить любую информацию (текстовую или медийную), которая находится в открытом доступе, например:

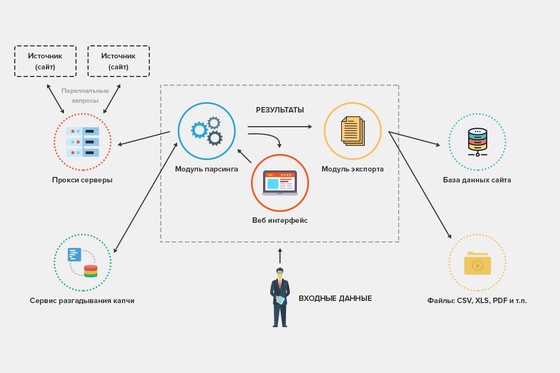

Алгоритм работы парсера

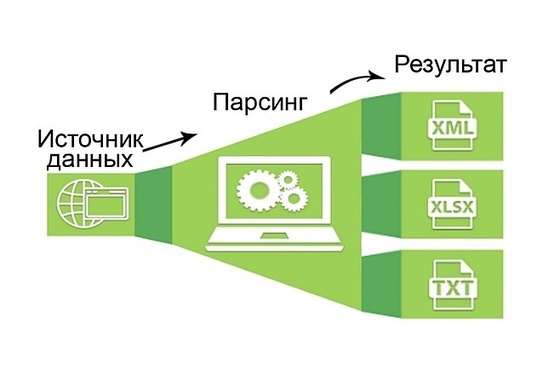

Тонкости процесса зависят от задачи, которая забивается в программы, но в остальном действия имеют следующую последовательность, схему:

Способы применения

Парсинг для начинающих начинается с анализа конкурирующих фирм, чтобы сформировать собственную ценовую политику и план продвижения, стратегию интернет-маркетинга. А уже уверенные пользователи одновременно используют парсеры и для изучения конкурентов, и для аудита своего ресурса, для сравнения полученных сведений. Такая работа в тесной связке помогает поддерживать конкурентоспособность на высоком уровне.

Как парсить данные

Можно пойти двумя путями – купить программу, которых представлено большое множество, или создать приложение собственными силами фактически на любом из языков программирования.

Как спарсить цену

Определение ценовой политики – это самая ходовая задача для приложений. Для этого необходимо посмотреть код анализируемого товара и ввести его в программу. Она автоматически подтянет другие позиции, отвечающие запросу. Сэкономить время и повысить эффективность можно, если ограничить круг страничек. Например, так он не будет искать по разделу с информационными статьями. Добавлять стоит категории и сами карточки продукции. Прописываются ссылки на них в карте XML.

Как парсить характеристики товаров

Для этого понадобится вручную определить код у каждого продукта, который вам требуется. Затем можно подвязать полученные сведения с автозаполнением полей в вашем интернет-магазине. Особенно актуально подтягивать описание, когда вы занимаетесь реализацией техники, автомобилей, смартфонов. Часто характерные особенности берутся на сайтах производителей. Они не могут отличаться уникальностью, поэтому поисковики за это не ругаются.

Как спарсить отзывы (с рендерингом)

Процедура аналогичная – копирование кода, а затем его ввод в приложение для парсинга. Но несколько отличаются последующие действия. Обычно комментарии открываются в тот момент, когда пользователь прокручивает страницу вниз, чтобы ознакомиться с ними. И тогда нужно снова залезть в настройки и изменить поле «Рендеринг» на JavaScript. В таком случае программа будет себя вести точно как юзер, прокручивая вниз контент до отзывов.

Как парсить структуру сайта

Это важное занятие, которым также часто занимаются новички. Основная задача – узнать, из каких разделов, подразделов и категорий состоит веб-ресурс, чтобы сделать аналогичные. Структурирование определяется, благодаря изучению breadcrumbs, или хлебных крошек в буквальном переводе. На самом деле термин подразумевает навигационную цепочку, которая выстраивается от начального элемента (корневого файла) до итогового.

Что нужно для этого сделать:

Теперь вы знаете, как сделать парсинг сайта интернет-магазина самостоятельно. Но не всегда удается правильно распорядиться полученной информацией, а также быстро обойти все существующие ограничения на поиск. В таком случае мы рекомендуем обратиться к компании по продвижению вебсайтов. Специалисты агентства SEMANTICA производят анализ конкурентов на начальном этапе работы с проектом, а заказчик получает готовый результат в удобном формате.

avtozenno.blogspot.com

Оптимизируйте сайт и получите больше трафика

Попробуйте полную версию Анализа сайта: найдите ошибки на главной и внутренних страницах и исправьте их с помощью советов сервиса. Ежедневный аудит и проверка позиций помогут оценить результаты.

Бесплатная версия:

Анализ только главной страницы

10 проверок в инструментах в день

Ограниченная частота проверки

Платная:

Анализ всех страниц сайта

Сравнение с конкурентами

Проверка позиций по запросам

Автоматический анализ сайта

Еженедельные отчеты на почту

Важные события

Чек-лист

Параметры домена

В истории найдено изменений за 2 года 6 месяцев. Первая дата: декабрь 2018.

Хотите увидеть весь график?

Доступно на платных тарифах.

Каждый день мы будем обновлять данные о вашем сайте, чтобы вы не пропустили важные события.

Описание:

Индекс качества сайта — это показатель того, насколько полезен ваш сайт для пользователей с точки зрения Яндекса.

При расчете индекса качества учитываются размер аудитории сайта, поведенческие факторы и данные сервисов Яндекса. Значение индекса регулярно обновляется.

Если у сайта есть зеркало, то показатель неглавного зеркала сайта будет равен показателю главного.

Показатель ИКС поддомена сайта, как правило, равен показателю основного домена.

Дополнительная информация:

Статьи по теме:

Данные теста были получены 27.09.2021 17:19

Описание:

Рядом с адресом сайта в результатах поиска Яндекса могут появляться знаки, основанные на данных о поведении пользователей. Такие знаки могут свидетельствовать об удовлетворенности пользователей и их доверии к сайту.

Популярный сайт — сайт получает этот знак, если имеет высокую посещаемость и постоянную аудиторию.

Выбор пользователей — знак получают сайты с высокой степенью вовлеченности и лояльности пользователей по данным Яндекса.

Статьи по теме:

Данные теста были получены 27.09.2021 17:19

В истории найдено изменений за 2 года 11 месяцев. Первая дата: февраль 2018.

Хотите увидеть весь график?

Доступно на платных тарифах.

Каждый день мы будем обновлять данные о вашем сайте, чтобы вы не пропустили важные события.

Описание:

Примерное количество проиндексированных страниц в выдаче Яндекса можно посмотреть через оператор site:, что мы и делаем. Он покажет результат поиска по URL сайта, но точную цифру страниц в индексе выдавать не обязан.

Точные данные Яндекс отображает в Яндекс.Вебмастере. График изменений количества находится в разделе «Индексирование сайта» — «Страницы в поиске».

Данные теста были получены 27.09.2021 17:19

В истории найдено изменений за 2 года 11 месяцев. Первая дата: февраль 2018.

Хотите увидеть весь график?

Доступно на платных тарифах.

Каждый день мы будем обновлять данные о вашем сайте, чтобы вы не пропустили важные события.

Описание:

Сколько страниц сайта Google точно проиндексировал, узнать невозможно. Поисковик не ведет базу данных по URL-адресам.

Примерное количество страниц в выдаче покажет оператор site:, на который мы ориентируемся. Число может быть искажено страницами, которые запрещены к индексу в robots.txt, но попали в выдачу из-за внешних ссылок на них.

Чуть более точное количество покажет раздел «Статус индексирования» в Google Search Console, но и эти данные могут быть искажены из-за применения фильтров.

Данные теста были получены 27.09.2021 17:19

Описание:

Примерное количество проиндексированных страниц в выдаче Яндекса можно посмотреть через оператор site:, что мы и делаем. Он покажет результат поиска по URL сайта, но точную цифру страниц в индексе выдавать не обязан.

Точные данные Яндекс отображает в Яндекс.Вебмастере. График изменений количества находится в разделе «Индексирование сайта» — «Страницы в поиске».

Данные теста были получены 27.09.2021 17:19

Описание:

Google сканирует сайты, чтобы находить зараженные ресурсы, фишинговые страницы и другие проблемы, которые ухудшают качество выдачи и пользовательский опыт. Благодаря этой информации поисковая система предупреждает пользователей о небезопасных сайтах. В случае, если сайт будет признан опасным, Google может понизить его в выдаче или удалить.

Дополнительная информация:

Данные теста были получены 27.09.2021 17:19

Описание:

Обычно заражение происходит из-за уязвимости, которая позволяет хакерам получить контроль над сайтом. Он может изменять содержание сайта или создавать новые страницы, обычно для фишинга. Хакеры могут внедрять вредоносный код, например скрипты или фреймы, которые извлекают содержимое с другого сайта для атаки компьютеров, на которых пользователи просматривают зараженный сайт.

Дополнительная информация:

Данные теста были получены 27.09.2021 17:19

С 2009 года Роскомнадзор контролирует распространение информации в интернете. Для этого ведомство в 2012 году создало реестр запрещенных сайтов, который пополняется ежедневно. Первыми под блокировку попадают сайты с запрещенным контентом. Также Роскомнадзор может заблокировать сайт за ФЗ 152 «О персональных данных».

Чтобы снять блокировку, нужно убрать материалы на сайте, из-за которых вы получили блокировку. После этого написать письмо на адрес: zapret-info@rsoc.ru.

Дополнительная информация:

Статьи по теме:

Данные теста были получены 27.09.2021 17:19

Рейтинг домена — 6 / 100

В истории найдено изменений за 1 год 4 месяца. Первая дата: март 2020.

Хотите увидеть весь график?

Доступно на платных тарифах.

Каждый день мы будем обновлять данные о вашем сайте, чтобы вы не пропустили важные события.

Описание:

Данные теста были получены 27.09.2021 17:19

Парсинг бесплатно: 30 программ, сервисов и фреймворков

В этой статье расскажу про программы, сервисы и фреймворки для парсинга, которые позволяют собирать данные бесплатно. В подборке представлены как полностью бесплатные инструменты, так и инструменты, предоставляющие ограниченный бесплатный период либо ограниченную функциональность, но в любом случае дают возможности, которых может хватить для решения тех или иных задач.

Парсинг – это автоматизированный процесс сбора данных с сайтов, применяется для сбора контента: цен конкурентов, описаний товаров, контактов для лидов, отзывов и рейтингов, файлов и для любых других задач, когда нужно собрать большой объем информации.

Условно инструменты для парсинга разделяются на две части. Одна из них – это разработка парсинга под задачу, этим занимаются программисты, которые часто используют разные языки программирования, например, Python или JavaScript, чтобы тщательно продумать логику будущего скрипта до деталей, что требует времени и вычислительных ресурсов, но в конечном итоге дает наилучшие результаты. Задачи при таком подходе решаются точно, как нужно, можно собирать данные с необходимыми условиями, скоростью и объемами.

Программы стоит выбирать, если вам нужно простое решение с быстрым стартом, не требующее знаний языков программирования. Конечно, использование программ не позволит решить любой кейс и возможности самих программ различны, но тем не менее это отличное решение для простых задач.

Screaming Frog SEO Spider – популярная программа, специализирующаяся на работе с SEO данными, имеет широчайший функционал для аудита сайтов, полное перечисление возможностей программы займет не одну страницу. При первом знакомстве интерфейс программы может показаться громоздким из-за множества вкладок и окон, но поработав некоторое время становится понятно, что он удобен, вкладки позволяют получить быстрый доступ к отчетам, окна удобно структурируют результаты парсинга.

В бесплатной версии программа предоставляет следующие возможности:

Бесплатная версия ограничена возможностью парсить до 500 URL адресов на сайте и если ваши потребности вписываются в ограничения программы, то внимательно присмотритесь к данному продукту. Screaming Frog быстр в работе, в силу популярности на эту программу написано множество обзоров и разобраться в базовом функционале не составит труда.

Полная версия программы предоставляет возможность парсить не только SEO данные, но и любую другую информацию с сайтов используя XPath (XML Path Language) — язык запросов к элементам XML-документа.

Некоторые сайты используют методы динамической загрузки данных на стороне клиента для создания асинхронных запросов. Такие данные проблема для простых парсеров, поскольку веб-контент не встроен в исходный HTML код. Easy Web Extract заявляет о возможности сбора таких данных, при тестировании программа справилась не со всеми сайтами, вам нужно проверить эту фичу на нужных вам сайтах.

Ограничения бесплатной версии:

Остальной функционал парсера доступен в бесплатной версии, программу можно использовать для сбора небольших объемов.

FMiner – инструмент для парсинга сайтов, работа которого построена на записи ваших действий и последующем воспроизведении записанных сценариев. Созданные таким образом последовательности действий (макросы), можно редактировать в визуальном формате, что позволяет использовать инструмент без знания языков программирования.

Программа работает с динамически подгружаемыми данными (AJAX), поддерживает работу с несколькими потоками, позволяет работать с результатами поиска и несколько выходных форматов. Программа имеет видеоуроки для быстрого старта, но страницы с мануалами не работают и последние обновления на сайте датированы 2015 годом, что говорит о том, что разработчик не следит за продуктом, но установочные файлы доступны и можно загрузить билд для бесплатного использования полнофункциональной версии программы в течении двух недель.

На сайте есть раздел с документацией, рассказывающий в краткой форме возможности и основы работы с программой.

Ограничения бесплатной версии:

Helium scraper – еще одна программа для парсинга данных с сайтов. Принцип работы с программой похож на работу с FMiner, только вместо визуального представления планируемых действий программа выводит код. В целом интерфейс при первом знакомстве не такой понятный как у предыдущих программ, но программа предлагает видеоуроки и базу знаний, которые помогут быстро разобраться с основами рабочего процесса.

По функциональности программа похожа на рассмотренные выше, но имеет ряд особенностей. Одно из ключевых заявленных отличий, это возможность работать с базами данных, до 140 Терабайт, конечно это не означает, что другие программы не осилят работу с большими базами данных, но, если планируете собирать много данных, стоит присмотреться к Helium scraper. Еще одна особенность — это возможность работы с API, вы сможете интегрировать запросы в свой проект.

Ограничения бесплатной версии:

Ограничения бесплатной версии:

В силу ограничения сбора, программа подойдет вам, если нужные данные находятся (или можно вывести) не дальше второй страницы.

Программа доступна только для Windows.

Screen-Scraper – программный комплекс для парсинга данных. Программа автоматизирует копирование текста с веб-страниц, переход по ссылкам, ввод данных в формы и их отправку, итерации по страницам результатов поиска, скачивание файлов (PDF, Word, изображения и т. д.). Программа может обрабатывать практически любой сайт, включая сайты, использующие динамически подгружаемые данные AJAX.

Ограничения бесплатной версии:

Программу сложно назвать интуитивно понятной, но на сайте разработчика имеются уроки, которые позволят понять принципы работы и быстро стартовать проект.

Облачные сервисы, как и программы для парсинга предоставляют доступ к функционалу бесплатно на определенных условиях, и вы можете воспользоваться услугами сервисов для решения своей задачи. Главное отличие от программ – парсинг выполняется на удаленном сервере и не тратит ресурсы вашего компьютера.

Octoparse – облачный сервис для парсинга данных с визуальным программированием парсера. Сильные стороны сервиса – множество статей объясняющих как пользоваться сервисом и хорошие лимиты бесплатной версии.

Ограничения бесплатной версии:

Mozenda – популярный облачный сервис для парсинга сайтов. Сервис предлагает визуальный метод захвата данных, для более сложных сайтов вы сможете использовать запросы XPath, если вы разработчик, то сможете создать сценарий парсинга точно отвечающий вашей задаче. Сервис предлагает месячный демо доступ, для настройки парсинга нужно установить приложение на компьютер, дальнейшая обработка происходит в облаке.

Ограничения бесплатной версии:

Diffbot – облачный сервис для парсинга работающий на алгоритмах машинного обучения и компьютерного зрения. Сервис автоматически определяет тип страницы URL-адресов и возвращает найденные данные для поддерживаемых типов страниц (статьи, карточки товара, изображения, обсуждения или видео).

Ограничения бесплатной версии:

Scraper api – сервис для парсинга требующий программирования. Особенность сервиса Scraper API меняет IP-адреса с каждым запросом из пула включающего миллионы прокси через десятки интернет-провайдеров и автоматически повторяет неудачные запросы, тем самым гарантирует сбор нужных данных. Scraper API также обрабатывает CAPTCHA. Парсинг осуществляется через безголовый браузер.

Ограничения бесплатной версии:

Сервис подойдет в случае, если вы умеете программировать на одном из языков, NodeJS, Python, Ruby или PHP и вам нужно получить данные с сайта с высокой степенью защиты.

Scrapy Cloud — это проверенная в боях облачная платформа для запуска парсеров, требующая знания языков программирования и предоставляющая гибкие инструменты для создания проектов со сложной логикой. Сервис предлагает интересный бесплатный тариф с безлимитным количеством данных, ограниченно только время работы – 1час.

Ограничения бесплатной версии:

Сервис подойдет в случае, если вы умеете программировать и ваш проект содержит сложную логику для извлечения данных.

ScrapingBee – сервис для парсинга сайтов использующий безголовый браузер и ротацию прокси. Сервис может рендерить Javascript, это позволяет парсить любой веб-сайт, даже одностраничники использующие React, Angulars, Vue.js или любые другие библиотеки. Большой пул прокси серверов поможет снизить вероятность блокировки и увеличить скорость сбора данных благодаря одновременному использованию нескольких браузеров.

Ограничения бесплатной версии:

Сервис требует программирования скриптов (CURL, Python, NodeJS, Java, Ruby, Php, Go), подойдет в случае сложной, кастомизируемой логики для извлечения данных и необходимости рендеринга JavaScript.

Apify – сервис для парсинга данных построенный по принципу магазина готовых решений. По сути, это шаблоны, настроенные на самые популярные кейсы: сбор данных с Amazon, Instagram, Booking и т.д. Работа происходит через обращение к API сервиса, все представленные шаблоны сопровождаются документацией, и вы можете поменять запрос, чтобы он в точности соответствовал вашей задаче.

Ограничения бесплатной версии:

Сервис требует умения вызова API, подойдет для парсинга популярных сайтов, имеет хорошие лимиты для бесплатного использования.

Web Scraper – сервис для парсинга который максимально упрощает извлечение данных с сайтов. Настройка парсера, происходит в визуальном редакторе посредством указания того, какие элементы нужно собирать, программирование не требуется. Web Scraper позволяет создавать карты сайта из различных типов селекторов. Эта система позволяет в последующем адаптировать извлечение данных к разным структурам сайта.

Ограничения бесплатной версии:

CrawlMonster – инструмент для парсинга SEO показателей сайта, вы можете сканировать, хранить и получать доступ к SEO-данным вашего веб-сайта, таким как контент сайта, исходный код, статусы страниц, распространенные ошибки, проблемы безопасности и многие другие.

Ограничения бесплатной версии:

eScraper – сервис позволяющий парсить любые сайты, ориентирован на электронную коммерцию и имеет простые интеграции с магазинами построенными на Magento, PrestaShop, WooCommerce или Shopify. Работает с динамически загружаемым контентом, например, раскрывающиеся списки, разделы “показать больше”, “следующая страница”, чекбоксы.

Ограничения бесплатной версии:

80legs – сервис для парсинга построенный на основе шаблонов. Приложения для сканирования 80legs используют методы Javascript, которые вы можете изменить в соответствии с любыми вашими требованиями к парсингу. Вы можете настроить, какие данные будут обрабатываться и по каким ссылкам переходить с каждого просканированного URL. Вы также можете использовать приложения для сканирования 80legs по умолчанию для сбора любых данных HTML, таких как ссылки, ключевые слова, метатеги и многое другое.

Ограничения бесплатной версии:

Phantom Buster – облачный сервис для сбора данных, предлагающий готовые решения для основных социальных сетей и других сайтов, например, Facebook, Twitter, Instagram, LinkedIn и т.д. Парсинг при помощи сервиса не требует умения программировать и позволяет легко выполнять стандартные для социальных сетей кейсы в автоматической режиме, такие как автоматическое отслеживание профилей, авто-лайки постов, отправка индивидуальных сообщений, прием заявок.

Ограничения бесплатной версии:

Ограничения бесплатной версии:

Сервис подойдет, если вам нужно получать данные из новостных источников и есть необходимость в исторических данных.

Parsers – сервис парсинга, извлекает данные из HTML страниц и импортирует их в excel, xls, xlsx, csv, json, xml файл. Сервис настраивается через расширение для браузера. Особенность сервиса – нужно выбрать необходимый тип данных только на одной, самой детальной странице сайта, далее технология сервиса найдет похожие страницы на сайте и извлечет необходимые данные. Парсинг работает автоматически на основе машинного обучения, нет необходимости указывать все страницы, каталоги и другие настройки.

Ограничения бесплатной версии:

Сервис подойдет, если вам нужно получать данные из новостных источников и есть необходимость в исторических данных.

Agenty – сервис работающий через расширение для браузера Chrome. Очень простое в использовании расширение для парсинга данных с помощью CSS-селекторов с функцией «укажи и щелкни» с предварительным просмотром извлеченных данных в реальном времени и быстрого экспорта данных в JSON / CSV / TSV.

Ограничения бесплатной версии:

Grepsr – расширение для браузера Chrome позволяющее простыми методами визуального программирования собирать данные с сайтов. Сервис предлагает интуитивно понятный интерфейс, API для автоматизации действий и интеграции с популярными системами управления документами, такими как Dropbox, Google Drive, Amazon S3, Box, также доступна выгрузка на FTP.

Ограничения бесплатной версии:

Web Robots – сервис работающий как расширение для браузера Chrome. Сервис прост в использовании, имеет интерфейс для визуального захвата данных, разобраться с ним не составит особого труда, главное преимущество – сервис автоматизирует действия. Функциональность сервиса так же проста, парсер подойдет для самых простых задач.

Ограничения бесплатной версии:

Data miner – сервис парсинга данных работающий через расширения для браузеров Google Chrome и Microsoft Edge, помогает собирать данные с различных сайтов с помощью визуального интерфейса. В Data Miner есть более 40 000 общедоступных шаблонов для множества самых популярных сайтов. Используя эти шаблоны, вы можете получить нужные данные в несколько щелчков мыши. Еще одна особенность – сервис позволяет работать со списком адресов, вы можете загрузить нужные страницы и быстро получить результат.

Ограничения бесплатной версии:

Scraper.AI – сервис парсинга данных работающий как расширения для браузеров Chrome, Firefox и Edge. Ключевая особенность Scraper.AI — это визуальное программирование парсера, не требующее работы с кодом. Так же сервис предлагает готовые шаблоны, которые настроены на сбор данных в Facebook, Instagram и Twitter.

Ограничения бесплатной версии:

Для использования фреймворков необходимо обладать знаниями языков программирования и в некоторых случаях нужны обособленные вычислительные мощности, использование библиотек для парсинга поможет реализовать задачу любой сложности и точно настроить проект под задачу.

Scrapy – это фреймворк для парсинга с открытым исходным кодом. Фреймворк написан на языке программирования Python и это одно из самых часто применяемых решений для сбора данных. Одно из основных преимуществ Scrapy – асинхронная обработка запросов. Это означает, что Scrapy не нужно ждать, пока запрос будет завершен и обработан, он может отправлять другие запросы или выполнять другие действия в этот же момент времени. Это также означает, что запросы могут выполняться, даже если при обработке какого-либо запроса возникает ошибка.

Это позволяет выполнять очень быстрый обход (одновременную отправку нескольких запросов отказоустойчивым способом), Scrapy также дает контроль над другими параметрами парсинга. Вы можете делать такие вещи как установка задержки загрузки между каждым запросом, ограничение количества одновременных запросов для каждого домена или IP-адреса и даже использовать расширение с автоматическим определением времени парсинга.

Scrapy имеет подробную документацию и большое комьюнити.

BeautifulSoup – еще один фреймворк на языке Python для парсинга данных из HTML и XML документов, имеет подробную документацию, требует дополнительных библиотек для открытия ссылок и сохранения результатов сбора данных. Он более прост по сравнению со Scrapy, BeautifulSoup стоит использовать, если задача не подразумевает распределение данных, не требуется реализация сложной логики, не нужно использовать прокси. Так же отличительная черта BeautifulSoup низкий порог входа, библиотека подойдет программистам даже с начальными знаниями, множество мануалов способствует быстрому освоению.

Selenium — это набор инструментов для автоматизации веб-браузеров с открытым исходным кодом, объединяет набор инструментов для управления, развертывания, записи и воспроизведения действия.

Сценарии могут быть написаны на различных языках Python, Java, C#, JavaScript, Ruby. Selenium настоящий комбайн для парсинга, позволяющий объединять не только браузеры, но и вычислительные мощности для решения задач. Этот инструмент стоит использовать, если перед вами стоят большие задачи и есть ресурсы для их реализации.

Grab — фреймворк на языке Python для написания веб-парсеров. Grab помогает создавать парсеры различной сложности, от простых 5-строчных скриптов, до сложных и асинхронных поисковых роботов, способных обрабатывать миллионы страниц. Фреймворк предлагает API для выполнения сетевых запросов и последующей обработки контента, например, для взаимодействия с деревом DOM HTML- документа.

Библиотека Grab состоит из двух основных частей:

В заключении расскажу о сервисе парсинга развитием которого я занимаюсь – iDatica. Компания занимаемся разработкой парсинга под задачи клиента. Мы очищаем и визуализируем данные, сопоставляем (матчим) товары, делаем это качественно, под ключ.

У нас нет бесплатного тарифа, почему нужны наши услуги, если есть готовые и даже бесплатные сервисы? Если коротко – сервисы требуют людей, которые будут с ними работать, требуют время на изучение функционала и не во всех случаях способны справиться с требования заказчика. Мы решаем все эти задачи.