vmkernel adapter для чего

Виртуальный сетевой контроллер для vmkernel (vmk)

Delphi site: daily Delphi-news, documentation, articles, review, interview, computer humor.

И в ESX, и в ESXi мы можем создать виртуальные сетевые адаптеры для VMkernel, для гипервизора. Нужны они для:

— подключения дисковых ресурсов по iSCSI в случае использования программного инициатора iSCSI;

— подключения дисковых ресурсов по NFS;

— (только на ESXi) управления сервером (на ESX для этого используется сеть Service Console).

Рис. 2.7. Управляющий интерфейс ESXi

См. подробности и требования к сети для соответствующих функций в разделах, им посвященных.

Виртуальные сетевые контроллеры для гипервизора создаются точно так же, как для Service Console (на ESX): Configuration ^ Networking ^ и затем:

— либо Add Networking для создания нового вКоммутатора и интерфейса VMkernel на нем;

— либо для существующего вКоммутатора Properties ^ Add на закладке Ports;

— в случае распределенных виртуальных коммутаторов пройдите Configuration ^ Networking ^ кнопка Distributed Virtual Switch ^ ссылка Manage Virtual Adapters ^ Add.

В любом случае как тип добавляемого интерфейса выбираем VMkernel. Укажем имя группы портов и настройки IP для создаваемого интерфейса.

Обратите внимание на то, что для интерфейса VMkernel у нас есть возможность установить три флажка (рис. 2.8).

Каждый из флажков разрешает передачу соответствующего трафика через данный интерфейс. Технически допускается любая комбинация флажков на од-

Рис. 2.8. Настройки интерфейса VMkernel на ESXi

ном виртуальном интерфейсе. Однако рекомендуется трафик разных типов разносить по разным физическим сетевым контроллерам, из чего следует создание отдельного интерфейса VMkernel под разные типы трафика гипервизора. Устанавливать флажки следует только по необходимости.

К тому же в случае использования ESXi через интерфейс с флажком «Management traffic» по умолчанию не пересылается трафик iSCSI и NFS. Если вы планируете использовать один интерфейс для управления и обращения к IP-СХД, то лучше всего создать несколько интерфейсов, пусть даже из одной подсети и на одном и том же виртуальном коммутаторе.

IT заметки на разные случаи жизни

IT заметки и статьи

Blog Stats

Немного о VMkernel и его конфигурации для сетевых сервисов

Немного о VMkernel.

VMkernel – это ядро VMware ESX/ESXi Server. Оно занимает слой виртуализации и управляет большинством физических ресурсов: процессорами, памятью, системами хранения данных, сетевыми контролерами и п.р. Кто то может заметить, что в VMware ESX Server есть Red Hat Enterprise Linux, так и есть, но роль линукса сводится только к тому, чтобы загружить машину и само ядро VMkernel, вот оно то и управляет всем. Сам линукс в ESX Server служит только для предоставления командной консоли, а также для установки агентов мониторинга железа и бекапа. Кстати в VMware ESXi Server тоже есть линукс, но он просто очень и очень сильно обрезан.

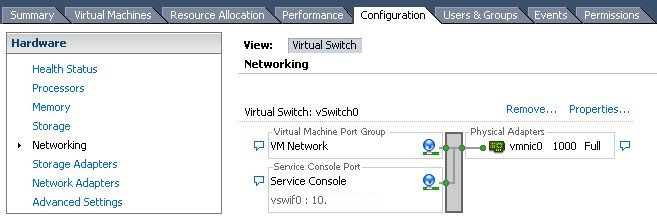

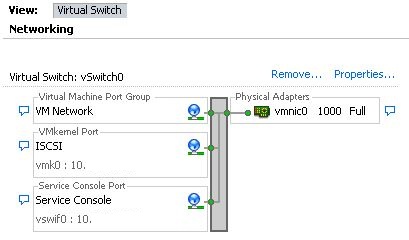

Открываем клиент vSphere и идем в раздел Configuration->Networking. В данном примере у меня на хосте 2-ве физические сетевые карты. Первая карта подключена vSwitch0, к которому подключены ВМ. Вторая карта подключена на vSwitch1, вот как раз на нем я и собираюсь создать порт VMkernel и гонять трафик.

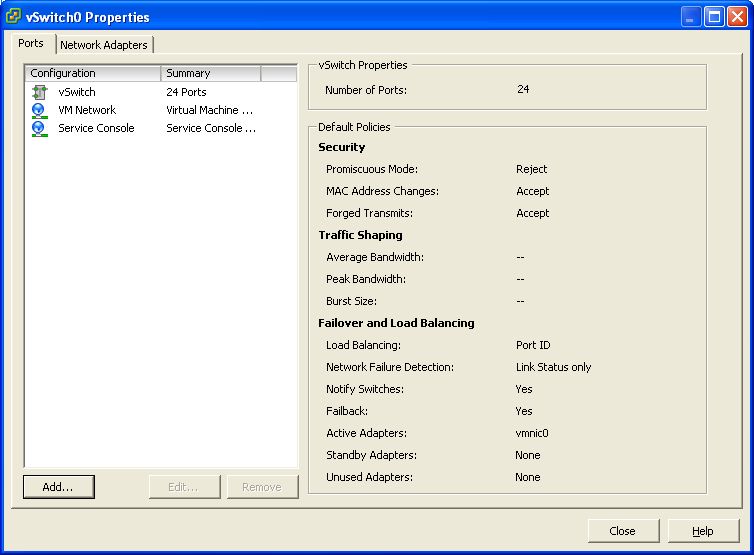

Жмем Properties на нужном нам vSwitch и в появившемся окне жмем Add.

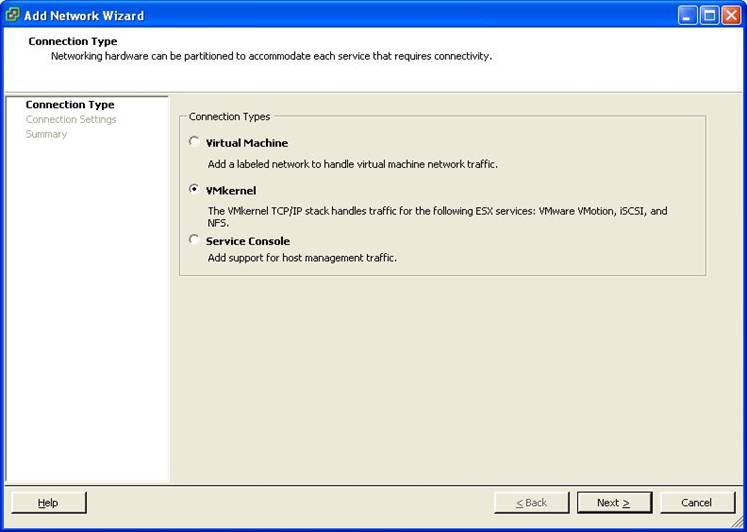

Потом выбираем VMkernel.

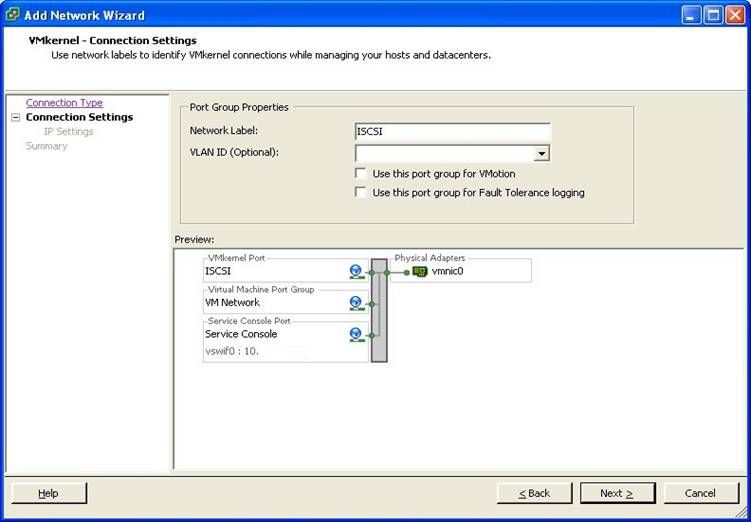

И просто забиваем нужные параметры. Думаю тут все понятно, имя порта и vlan id если необходим.

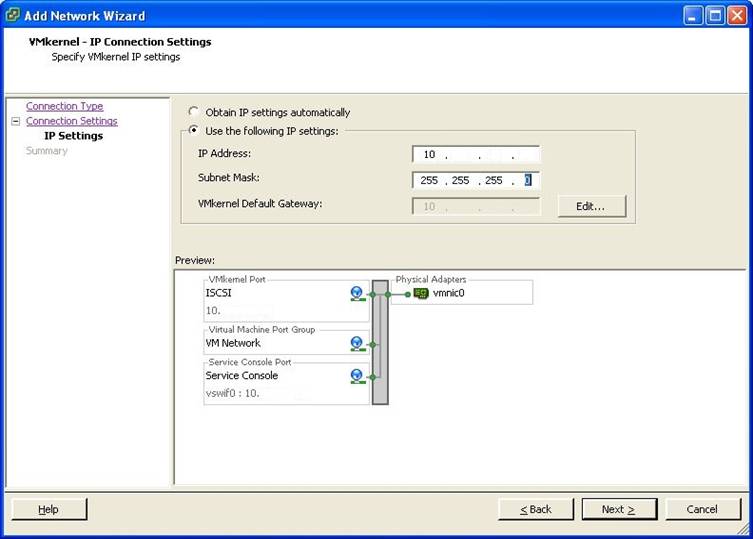

Далее сконфигурируем IP адрес, маску, и шлюз для VMkernel порта.

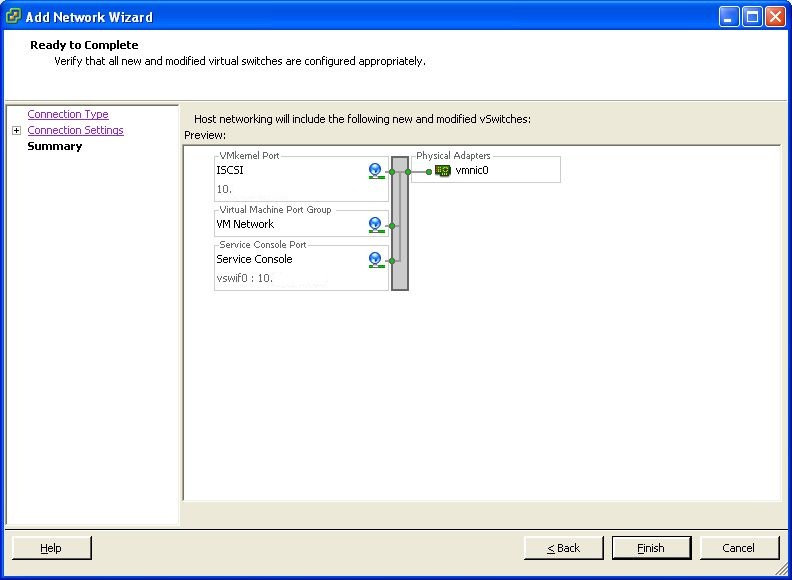

Жмем Next. Смотрим суммарную инфу и жмем Finish. После завершения мастера создастся порт VMkernel со своим сетевым интерфейсом.

Остается только проверить доступен ли только что созданный сетевой интерфейс VMkernel. Просто пингуем с машины которая находится в одной сети с портом VMkernel его интерфейс или же можно с консоли ESX пингануть какую либо машину в сети. Для пинга через интерфейс VMkernel используется команда vmkping.

Вот и вся конфигурация. Далее теперь можно сконфигурировать VMotion, iSCSI и NFS. Но это уже выходит за рамки этой публикации.

Создаем порт VMkernel (для ISCSI, vMotion, NFS и FT) на стандартном и распределенном коммутаторе vSwitch

Порт VMkernel необходим на любом сервере ESX, на котором планируется развернуть любую из перечисленных служб:

Без порт типа VMkernel ни одна из этих служб не будет работать на сервере ESX/ESXi.

В данной статье описывается процедура создания и настройки порта VMkernel на стандартном vSwitch (для распределенного distributed vSwitch – вся процедура точно такая же, за исключением того, что все операции выполняются в окне DVS view) на сервере ESX/ESXi.

Мы подразумеваем, что у вас уже создан виртуальный коммутатор vSwitch (стандартный или распределенный), которому презентованы карты pNIC, соединяющие его с физической сетью передачи данных.

1. Подключитесь к серверу ESX с помощью клиента vSphere.

2. Перейдите на нужный вам хост ESX, и затем выберите вкладку «Configuration» и найдите в ней раздел «Networking».

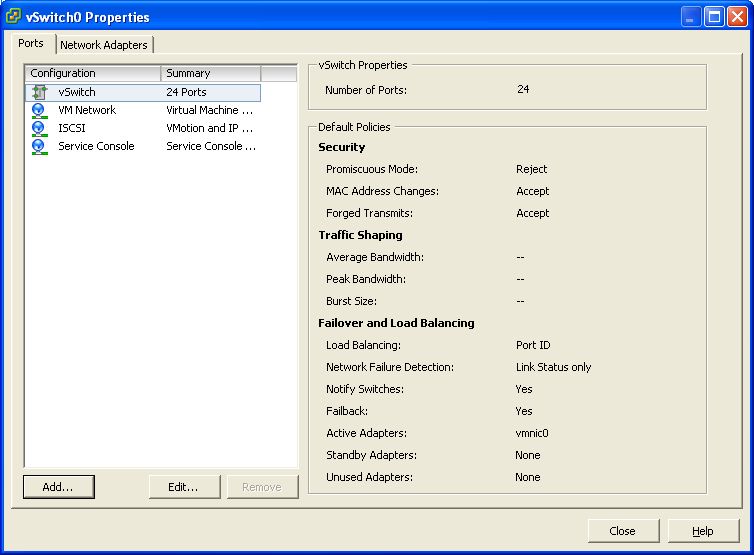

3. На выбранном vSwitch (который соединен с внешней физической сетьб при помощи сетевой карты pNIC, щелкните по ссылке «Properties».

4. В свойствах виртуального коммутатора vSwitch на вкладке «Ports», нажмите кнопку «Add…»

5. В качеств типа соединения укажите «VMkernel», затем нажмите Далее.

6. Задайте имя порт VMKernel (например, iSCSI – если он будет использоваться для передачи траика iSCSI).

В том случае, если на физическую карту pNIC подается транк, вам необходимо указать желаемый VLAN ID (хорошим тоном считается изолировать трафик VMKernel внутри отдельной VLAN, используемого для передачи данных между устройствами хранения ).

В том случае, если порт планируется использовать только для передачи данных между на систему хранения (iSCSI или NFS), можно нажать кнопку Next..

В том случае, если порт планируется задействовать под различные службы VMkernel (iSCSI, NFS, vMotion и FT), придется отметить галочками соответствующие опции, а затем нажать Далее.

7. Введите IP адрес порта VMkernel. Обычно порты VMkernel и service console находятся в разных подсетях (в разных VLAN). Укажите маску подсети, шлюз по-умолчанию для трафика VMkernel, а затем нажмите Next.

8. Просмотрите настройки создаваемого порта VMkernel, в том случае, если вас все устраивает, нажмите кнопку Finish.

9. В результате создастся новый порт VMkernel, который будет доступен в свойствах vSwitch. В случае необходимости настройки порта VMkernel могут быть отредактированы из этого окна. Нажмите кнопку Close.

10. Новый порт VMkernel и его IP адрес появятся и в окне графического представления сети (вкладка «networking»).

Теперь, когда порт VMKernel создан, можно приступить к настройке хранилищ iSCSI на сервере ESX.

Развертывание VMware Virtual SAN

Jan 13, 2017 · 12 min read

VMware Virtual SAN (или vSAN) — концепция распределенного хранения данных, полностью интегрированная с VMware vSphere на уровне кластера. vSAN — это программная СХД, позволяющаяся абстрагироваться от “железного” хранилища данных и работать с пулами ресурсов, не заботясь о том, где размещены данные виртуальных машин. vSAN собирает из серверов софтварное хранилище, доступное для всех серверов кластера виртуализации, таким образом, позволяя объединить в сервере его вычислительные мощности и функции хранения данных в единый кластер vSphere. Масштабирование Virtual SAN происходит через добавление блока, роль которого выполняет сервер, а управление происходит через единую консоль — vCenter Server.

Концепци я vSAN заключается в том, что на каждом хосте ESXi может быть от 1 до 5 дисковых групп, которые в свою очередь содержат:

Носитель, отданный для организации vSAN и объединенный в дисковую группу, используется полностью для организации системы хранения, его нельзя совместно использовать для других целей. Дисковые группы объединяются в пул, доступный всему кластеру vSphere, и организуют общее “внешнее” и отказоустойчивое хранилище, для передачи данных которого используется собственный протокол (FC, iSCSI, или NFS для обмена данными не нужны). Данные дисковых групп и блоки “четности” дублируются на одном, или нескольких хостах, в зависимости от выбранных параметров отказоустойчивости vSAN:

vSAN предоставляет два метода обеспечения отказоустойчивости:

vSAN позволяет по-разному обеспечивать отказоустойчивость для различных ВМ или их дисков: в рамках одного хранилища можно для критичных к производительности ВМ привязать политику с зеркалированием, а для менее критичных ВМ — настроить Erasure Coding.

vSAN представляет из себя объектное хранилище, данные в котором хранятся в виде объектов, или “гибких контейнеров” (flexible containers), распределенных по всему кластеру. Управление хранением осуществляется с помощью политик Storage Policy Based Management. vSAN допускает изменение политики хранения без остановки ВМ, запуская в фоне процессы перераспределения. При распределении объектов по кластеру vSAN контролирует, чтобы компоненты корректно распределялись по разным узлам, или доменам отказа (fault domain).

Классическая организация vSAN, с использованием хостов ESXi (возможно так же использование vSAN Appliance и Storage Appliance — об этом чуть ниже), не требует дополнительных плагинов к vSphere — для построения vSAN используются хосты ESXi, а управление доступно через vCenter. vSAN не требует нарезки LUN-ов и файловых шар, презентования их хостам и организации внешнего хранилища и выделенной сети хранения.

Для организации Virtual SAN можно использовать:

При планировании инфраструктуры vSAN и подборе оборудования можно ознакомиться с примерами конфигураций, изложенными в виде:

Рекомендуется так же ознакомиться с официальной документацией:

Развертывание VMware Virtual SAN Appliance.

или открываем в vSphere Client пункты меню:

и открываем скачанный OVA-темплейт. В открывшемся мастере будет предложен масштаб для деплоймента (до 10, до 500, или более 500 виртуальных машин), для каждого из которых свои требования к ресурсам виртуальной машины (рис. 1).

Cloud Geek

Рубрики:

Последние комментарии

Метки

Архив

Немного о VMkernel и его конфигурации для сетевых сервисов.

Расскажу немного о VMkernel и его конфигурации для сетевых сервисов. Мысль создание этого дока пришла ко мне после разговора с одним моим знакомым, которому пришлось объяснять, что такое VMkernel, что с ним делать и с чем его едят. 🙂

Немного о VMkernel.

VMkernel – это ядро VMware ESX/ESXi Server. Оно занимает слой виртуализации и управляет большинством физических ресурсов: процессорами, памятью, системами хранения данных, сетевыми контролерами и п.р. Кто то может заметить, что в VMware ESX Server есть Red Hat Enterprise Linux, так и есть, но роль линукса сводится только к тому, чтобы загружить машину и само ядро VMkernel, вот оно то и управляет всем. Сам линукс в ESX Server служит только для предоставления командной консоли, а также для установки агентов мониторинга железа и бекапа. Кстати в VMware ESXi Server тоже есть линукс, но он просто очень и очень сильно обрезан.

Конфигурирование сетевых сервисов VMkernel.

Как я уже выше писал, для работы VMotion, инициатора iSCSI и NFS необходимо сконфигурировать стек TCP\IP VMkernel. Конфигурация довольна, проста и заключается в добавление порт группы VMkernel к vSwitch на через который должен течь трафик сетевых сервисов iSCSI, NFS, VMotion. Все хватит теории, я больше люблю практику. 🙂

Открываем клиент vSphere и идем в раздел Configuration->Networking. В данном примере у меня на хосте 2-ве физические сетевые карты. Первая карта подключена vSwitch0, к которому подключены ВМ. Вторая карта подключена на vSwitch1, вот как раз на нем я и собираюсь создать порт VMkernel и гонять трафик.

Жмем Properties на нужном нам vSwitch и в появившемся окне жмем Add.

Потом выбираем VMkernel.

И просто забиваем нужные параметры. Думаю тут все понятно, имя порта и vlan id если необходим.

Далее сконфигурируем IP адрес, маску, и шлюз для VMkernel порта.

Жмем Next. Смотрим суммарную инфу и жмем Finish. После завершения мастера создастся порт VMkernel со своим сетевым интерфейсом.

Остается только проверить доступен ли только что созданный сетевой интерфейс VMkernel. Просто пингуем с машины которая находится в одной сети с портом VMkernel его интерфейс или же можно с консоли ESX пингануть какую либо машину в сети. Для пинга через интерфейс VMkernel используется команда vmkping.

Вот и вся конфигурация. Далее теперь можно сконфигурировать VMotion, iSCSI и NFS. Но это уже выходит за рамки этой публикации.